efikkan

-

Innlegg

24 979 -

Ble med

-

Besøkte siden sist

-

Dager vunnet

1

Innholdstype

Profiler

Forum

Hendelser

Blogger

Om forumet

Innlegg skrevet av efikkan

-

-

Hvis det er en seriøs aktør sin database som blir lekket så er passordene hashet. Hashing er en irreversibel matematisk funksjon, og passordene lagres ikke i klartekst. Det betyr at hver gang noen logger inn så hashes det passordet og sjekkes opp mot det hashede passordet i databasen. Dersom databasen lekkes så må den som skal finne ut passordet ditt prøve alle mulige passord siden det ikke er mulig å regne seg baklengs fra f.eks. c4da71e67e68d4e2dd6bdac02de57d45 til "passord". Hvis passordene i tillegg er saltet med unike salt så kan heller ikke en passorddatabase brukes. Det betyr at den som har fått tak i databasen må bruteforce hvert enkelt passord kjempelenge, og til lengre passordet ditt er til lenger tid vil dette ta.Hva har det å si hvis passordet er komplex når det blir lekket uansett?

Like godt å ha ett enkelt passord sånn det er enkelt å gi ifra seg til bekante når du trenger det.

Dessverre kan mindre seriøse nettsider, forum og nettbutikker finne på å lagre passord i klartekst, og da kan det naturligvis misbrukes direkte. Da håper jeg for din skyld at passordet er unikt slik at den som får tak i det ikke kan bruke det til å misbruke andre tjenester du er medlem av. En måte å håndtere denne risikoen på er å bytte ut passord ofte, og da trenger du en passordsafe.

Det der er noe av det dummeste du kan gjøre.DetteErMittPassord4f.eks#hw

DetteErMittPassord4f.eks#google

DetteErMittPassord4f.eks#icloud

DetteErMittPassord4f.eks#whatever

Lag ett passord for hver nettside du er på. Sånn får du sikkert passord.

Hvis du er medlem på en tvilsom nettside som lagrer passord i klartekst og den databasen lekkes så kan vi plutselig gjette alle passordene dine!

I stedet for å lage mange "halvgode" passord så trenger du bare ett eller to kjempegode. Så lærer du deg å bruke en passordsafe som KeePassX, og genererer så lange passord som mulig til hver enkelt tjeneste. Passordene bør du bytte ut én gang i året, eller oftere for mer tvilsomme tjenester. Bruk av passordsafe burde være det første alle lærte etter mus og tastatur.Dei beste passordene har desse eigenskapane:

-Langt, minst 10 tegn, helst fleire enn det

-Vanskelig å gjette

-Lett å huske

Det finnes også nettbaserte passordsafer som LastPass, men da må du stole på en tredjepart og det er ikke lenge siden sist der var utfordringer med slike løsninger.

Hver gang det diskuteres passord så må noen bringe frem den XKCD-stripen med feil. Randall Munroe har hverken forstått matematikken bak entropi eller forstått hvordan moderne bruteforcing fungerer da han laget stripen:Andre foretrekker passord med tilfeldige tegn for å føle seg sikre. Problemet då blir at det blir vanskelig å huske passordet. Då har folk ein tendens til å holde passordet for kort, då blir det lett å brute force passordet uansett.

Måten eg foretrekker å lage passord på er å skrive ein setning som ikkje gir meining eller berre ein haug med ord som ikkje høyrer sammen. Då får du et langt passord som er vanskelig å gjette siden det ikkje gir meining og det er lett å huske.

Et standard eksempel på et slikt passord er "correct horse battery staple" sjå https://xkcd.com/936/. Ja du kan bruke mellomrom i passordet ditt og disse mellomrommene er med på å gjere passordet sikrare. Ja det går fint å berre skrive lower case uten å bruke tal og spesialtegn i passordet ditt. Så lenge det er vanskelig å gjette og er langt nok så er passordet ganske sikkert.

- Et passord på 11 tilfeldige tegn har en entropi på 65-73 bit (avhengig av om spesialtegn tillates), stripen påstår "28 bit".

- Forklaringen til stripen bruker en ordbok med 7776 ord som eksempel. Fire tilfeldige ord gir da en entropi på ~51 bit.

- For hver bit med entropi kreves det dobbelt så mange forsøk, 65 bit er 16384 ganger bedre enn 51 bit.

- Om du så bruker en stor ordbok på 50.000 ord (inkl. variasjoner av samme ord, populære navn, stedsnavn osv.) så får du fremdeles en entropi på ~62 bit.

Nå er ikke 11 tegn nok til et godt passord, men du ser allerede der at det er betydelig bedre enn en rekke av vanlige ord. Nøkkelen her er at entropien avgjøres av enkleste måte du kan gjette deg til passordet, så hvis passordet ditt består av vanlige ord så er det åpenbart mye raskere å gjette vanlige ord enn alle mulige rare tegn. Det finnes allerede bruteforceing som bruker ordbøker til gjetting, så det er mange passord som lever farlig. Det passord er sterkt om det er vanskelig å gjette for andre.

-

1

1

-

-

Jada, selvfølgelig, er ikke uenig i at høyere kvalitet absolutt kan være på sin plass om man har behov for det.

Nå kan det være fordelaktig med borrelås som faktisk sitter uten en ende som bøyer seg av, og som er smidig nok til at den kan brukes flere steder enn en stiv billig-borrelås.Det er kvalitetsforskjell på dette som alt annet, men samtidig så er det en ganske "enkel jobb" for en borrelås. Det er ikke nødvendigvis slik at man trenger veldig høy kvalitet for å bunte noen kabler med et bånd som kanskje åpnes bare et ensifret antall ganger i levetiden.

For å understreke poenget; når borrelåsen sitter bedre så trengs det også mindre, med billig-borrelås trengs det ofte en ekstra omgang bare for at det skal sitte godt nok på en tykk kabel. Jeg prøvde ut Velcro etter anbefaling fra personer som bruker det i datasentre og større installasjoner. Det finnes også borrelås med løkke på enden som du hekter på én ledning og snurrer rundt en bunt, men når du ikke har det tilgjengelig så sitter faktisk Velcro godt nok med en "løkke" av én omgang rundt en ledning.

-

Nå kan det være fordelaktig med borrelås som faktisk sitter uten en ende som bøyer seg av, og som er smidig nok til at den kan brukes flere steder enn en stiv billig-borrelås.Det er kvalitetsforskjell på dette som alt annet, men samtidig så er det en ganske "enkel jobb" for en borrelås. Det er ikke nødvendigvis slik at man trenger veldig høy kvalitet for å bunte noen kabler med et bånd som kanskje åpnes bare et ensifret antall ganger i levetiden.

-

Problemet så langt har vært at 10 Gb/s har vært forbeholdt servere, selv om det har eksistert i mange år. Haswell-E "skulle" egentlig leveres med 10 Gb/s ethernet som standard, men det ble nok kuttet pga. kostnader. Men straks Intel velger å inkludere det i plattformen så vil der også komme mengder av switcher for arbeidsstasjoner.

-

Hva _trenger_ du mer enn 1G til, som privatperson, i dag? Husk at "trenger" viser til konkret behov, og ikke bekvemmelighet.Vel, saken er vel at mange av oss trenger mer enn 1 Gb/s, det betyr ikke at vi trenger hele 10 Gb/s ennå.

Forstå meg rett, 10G er fint og gøy, men ser for meg mange konstruerte behov og problemstillinger.

Som sagt trenger jeg nok ikke 10 Gb/s ennå, men jeg trenger definitivt mer enn 1 Gb/s. Svært mange av oss har en del data, enten det er mediefiler eller bilder og vi blir gjerne holdt tilbake av treg overføringshastighet. Mange har kjøpt seg NAS eller lignende og skal stadig overføre mange hundre GB med data. Helt vanlige folk som bruker teknologi har god bruk for dette i dag.

Om få år når jeg skal bygge nytt hus så skal jeg selvsagt dimensjonere for 10 Gb/s i hele huset, selv om bare et mindretall av enhetene vil være tilkoblet med nettverkskort som utnytter hele potensialet. Kostnadene for bedre kobberkabler er marginale, så den investeringen bør alle som bygger i dag gjøre allerede nå. Jeg håper at innen de neste par-tre årene så vil der komme litt billigere switcher og nettverkskort som gjør det mer overkommelig.

-

2

2

-

-

Kabelbånd med borrelås får du kjøpt på flere dataforretninger, men de billigste har vi funnet hos Clas Ohslon. Da får du en pakke på 10 stykker for 40 kroner, og de er brede nok til at du fint kan klippe dem i to på langs.

De kabelbåndene fra Clas Ohlson er elendige og holder ikke lenge.

Dere har vel lesere som vet om Ebay, så hvorfor ikke tipse om det slik at man heller kan kjøpe 100 for 20 kroner...

Vær alltid forsiktig med hva du bestiller. Der finnes mengder av billig borrelås på nettet og dette omtales som regel som "velcro", selv om det ikke er i nærheten av kvaliteten til ekte velcro. Jeg har brukt mye billigløsninger og ekte vare, og det er enorm forskjell. Du kan sikkert finne 25m billig-borrelås til 50 kr, men ekte velcro koster gjerne 250-300 kr for 25m.

Uansett bør alle husstander ha en rull med velcro:

En slik rull kan kuttes opp i lengder tilpasset et hvert behov.

-

1

1

-

-

Vel, saken er vel at mange av oss trenger mer enn 1 Gb/s, det betyr ikke at vi trenger hele 10 Gb/s ennå.

-

1

1

-

-

Ja, trøblete IPX-støtte var grunnen til at jeg la bort RA2.

-

Red Alert 2 var det siste brukbare C&C-spillet, men var likevel ikke like solid som Red Alert og Tiberian Dawn. Rundt andre halvdel av 90-tallet var gullalderen for RTS-spill med solide titler som Tiberian Dawn, Warcraft II, Red Alert, Starcraft, Tiberian Sun, Age of Empires II og så Red Alert 2 i 2000. Av disse fire seriene var det bare Starcraft som klarte å videreføre de solide seriene fra "RTS-gullalderen".

Selv om samtlige av overnevnte spill hadde en historie og de fleste små videosnutter mellom oppdragene så var det ikke historiene som gjorde spillenes suksess. Folk kjøpte C&C og Warcaft fordi det var moro i nettverk, og C&C gjorde det geniale sjakktrekket at spillets to CDer kunne brukes til at to kompiser kunne spille mot hverandre med ett spilleksemplar*. Strengt tatt kunne de kuttet ut hele historiedelen og fokusert alle ressurser på å lage et solid og balansert strategispill. Noe av det som ødela Red Alert 2 var nettopp fokuset på en dårlig historie og konsekvensene det fikk på spillets enheter.

*) Red Alert hadde også en "hemmelig" deaktivering av kopisperren hvor alt som skulle til var å lage en snarvei til ra95.exe med parameteren -nocd og legge inn de nødvendige mix-filene. Så der kunne alle spille sammen

-

1

1

-

-

VR har enormt med oppmerksomhet i media, men om det har reelt engasjement i spillindustrien er en annen sak. Selv når konsument-VR blir modent så vil det forbli et nisjemarked for blant annet simulatorer og en rekke førstepersonsspill. Vi kommer nok ikke til å komme til det punktet der det blir en selvsagt del til en spille-PC, og at majoriteten av spill utnytter det.Det virker som VR har et skikkelig moment i både kameraindustrien, telefonindustrien og spillindustrien, samt at det er noe som interesserer store folkemasser (både lesertall og salgstall viser det). Jeg liker det også og skal bruke litt penger på slik morro.

Det er helt klart at det på sikt vil trengs en standard for dette, men på nåværende eksperimentelle tidspunkt er det helt som forventet at hver aktør eksperimenteter med sitt. Om vi skulle sittet og ventet på en komité før noe kunne fungere så hadde utviklingen tatt mange flere år. Jeg ser frem til det tidspunktet VR har mer stabilisert seg, for nå med Oculus, Valve, Google og Sony med hver sine APIer, samt et par-tre tredjepartsløsninger (som jeg vet om) så blir det håpløst for utviklere å satse på alle disse.Det vi trenger er at alle blir enig om en felles standard for å presentere denne typen innhold.

Du er inne på noe her. Mange glemmer at nesten alle etablerte standarder har startet som en eller flere proprietære standarder eller som resultat av evaulering av proprietære standarder. Komitédrevet innovasjon er svært sjelden, så som oftest er vi avhengige av at noen tar ledelse og drar med seg industrien fremover.Neppe. La de forskjellige selskapene ha krigen sin. La de utmanøvrere hverandre. Overrasske hverandre og utvikle nye løsninger. Å sette en standard så tidlig i prosessen - før noe i det hele tatt har truffet markedet - vil være å sakke ned utviklingen betraktelig.

Det er likevel en fare for at situasjoner kan ende i formatkrig og innlåsing til plattformer. Enkelte aktører er verre på dette en andre, *kremt*Apple*host*, så det er alltid avhengig av gjensidig samarbeidsvilje fra alle parter.

Nei her er du som roter. Om noe er en standard har lite med hvorvidt det er en åpen løsing eller ikke. En standard er en spesifikasjon som er ratifisert av et standardiseringsorgan, enten det er proprietært eller ikke. Det finnes til og med graderte (militære) standarder.Du misforstår hva standard er for noe. Hint: proprietære løsninger er den rake motsetningen. Det er ingenting i veien for å lage en standard så fleksibel at den kan tilpasses både ulike produsenter, produkter og måter å gjøre ting på.

Problemet er at alle ønsker å komme ut på markedet og ta markedsandeler, ikke vente i 3-4 år på at de skal først bli enige om en spesifikasjon med mange utestede løsninger. Selv om noen av oss har kjent til eksperimentelle VR-løsninger i mangfoldige år så har ikke arbeidet med VR-støtte i drivere og spillmotorer vært jobbet med før de siste par år. Derfor kan vi forvente et par år til med "kaos" i markedet, med inkompatible løsninger og spinkel spillstøtte. Forhåpentligvis vil de gode aspektene fra ulike løsninger føre frem til en standard på et tidspunkt, som må blant annet åpne for tilpasning av den enkelte VR-brilles linsegeometri.Skjønner virkelig ikke hva som skulle vært fordelen av om Google, Apple, MS, FB osv hadde gjorde sine VR-løsninger inkompatible med de andre. Det ville hemmet kjøpelysten og gjennomslaget i markedet.

-

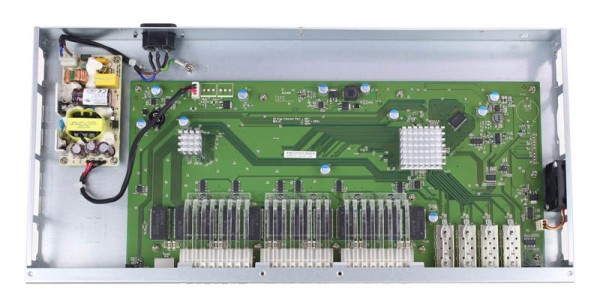

Som man ser kunne denne vært 20-30% mindre om psuen var laptop format med EU 2 pins plugg.

Så det er noe irriterende syns jeg. Selv om den muligens er det beste\billigste man kan finne i dag.

Står også viften finnes bedre så jeg regner med den støyer tilsvarende laptoper men ikke helt lydløs.

Usikker på strømforsyningen burde være bedre issolert?

Enten det er snakk om switcher eller routere så synes jeg det er glimrende at de er "unødvendig" romslige og luftige. Alt for mye konsumentutstyr er så kompakt som mulig, og blir svært varme under bruk som er med på å korte ned på levetid og redusere stabilitet. Mange av oss her har nok et modem, en router, en switch og kanskje en NAS stående i et skap eller en bod, og da er det en enorm fordel om disse kan plasseres over hverandre uten at kjøling blir et problem.

-

2

2

-

-

Hva legger du i "billigdisker"? Det er ganske stor forskjell mellom forskjellige konkrete konsumentdisker med tanke på feilrate, men samtidig er det mange tester som viser at forskjellen mellom enterprise og desktop som grupper er små eller kanskje tilogmed ikke til stede.

Til lagring av viktige data ville jeg valgt WD Black eller enterprise-disker, disker som er ment til å vare i 5 år med last. Det er forskjell på holdbarhet til disker, deriblant er MTBF en indikasjon på dette selv om det ikke kan omregnes til forventet levetid. Du tenker kanskje på testene til Backblaze? Vel de sier ingenting om hva de ulike diskene har blitt brukt til.

-

Slike disker kan kanskje være greie til mediefiler på en NAS, men jeg vil sterkt fraråde slike "billigdisker" til lagring av viktig data. Noe av det dummeste jeg ser er at folk kjøper slike billigdisker til sikkerhetskopi, på tross av at de ikke er ment til å vare i mange år. Siden mange har en mindre andel viktig data så kan ulike typer disker til ulike formål være en grei løsning.

Den største utfordringen for mange som ønsker seg et passe stort RAID-volum er kontrollere. Noen brikkesett har så lite som fire SATA-porter, andre har seks. Å spre RAID-sett over flere kontrollere er en dårlig idé, og operativsystemet bør også holdes på en egen disk tilkoblet brikkesettet. Dermed blir ofte en egen kontroller nødvendig for et greit RAID, og det er smart uansett med tanke på stabilitet.

Software-løsninger som ZFS eller Btrfs gir deg mange muligheter. Jeg har litt erfaring med ZFS, enkelt å sette opp flere RAID-lignende array parallelt, f.eks., og man kan sette det opp slik at flere enn 2 disker kan feile (RAIDZ3).

ZFS er teknisk interessant siden det tar både jobben som filsystem og som volume manager som gir en rekke muligheter vanlige filsystemer ikke kan på toppen av et RAID. Noen interessante muligheter i ZFS er copy on write, periodisk integritetssjekk, SSD-cache, effektiv deduplisering, filrevisjoner, osv. ZFS kan altså blant annet konfigureres til å finne skader i filer, noe et "vanlig" filsystem som sitter og holder på filer i årevis ikke vil gjøre av seg selv.

Men den store kompleksiteten til ZFS er også svakheten, for selv om ZFS er glimrende til å finne skadede innhold i filer (f.eks. en hel disk svikter) men derimot ekstra sårbart for skader på selve filstrukturen. Skader på filsystem er absolutt ikke uvanlig. Jeg ville nok vurdert ZFS om jeg skulle bygge et stort volum av ikke-kritisk data, men jeg stoler ikke på det til hva som helst.

-

1

1

-

-

Slike artikler bør inneholde en skarp advarsel om at de fleste slike kampanjer aldri ender i et ferdig produkt selv om mange når finansieringsmålet. Det er takket være slik oppmerksomhet at så mange tvilsomme kampanjer klarer å lure folk for så mye penger. $3.329 for en enkel konseptvideo blir grei timesbetaling.

For de som trenger hindringer for å åpne snusboksen sin så finnes der allerede "bedre" løsninger.

Hvis folk har så mye penger å brenne, så er der fremdeles noe plass på min konto.

-

Både Chrome og Firefox bruker GPU til rendering, og vil også spise litt minne fra skjermkortet. Dette er en vanlig kilde til stutter.Vel, mest sannsynelig, men det hjelper å avslutte firefox og chrome. Da er alt fint, aner ikke hvorfor.

-

1

1

-

-

Det er alltid fint når ting er åpent. Men i en rekke tilfeller så er koden i stedet tilgjengelig under lisens, så utviklingsmessig burde ikke dette være et problem for spillutviklere.

Er du uenig i at det hadde vært bedre med åpen kildekode på Gameworks-biblioteket?Spillutviklere kan også velge en GameWorks-lisens hvor de får tilgang til kildekode.

Hvis kildekoden var åpen kunne det jo vært noen som klarte å finne raskere løsninger på både AMD- og Nvidia-kort.

Det skjer jo nå med det siste Tomb Raider-spillet som skal bruke en variant av AMDs TressFX som visstnok kjører bedre på begge produsentene.

Dessverre er koding for nedprioritert i alt for mange spillprosjekter, så jeg ser ikke for meg at mange har plass i budsjettet til å optimalisere et tredjepartsbibliotek.

-

2

2

-

-

Kan du forklare litt mer hva du mener her? 1440p er ikke en enhet for pixeltetthet i seg selv.Jeg kommer nok til å vente et par generasjoner før jeg kjøper ett eksemplar, helst til oppløsningen er høy nok til å matche 1440p i pikseltetthet i skarpdelen av synsfeltet. Om noen år skal jeg nok bygge meg en liten cockpit som den skal brukes i...

Beklager, det var dårlig forklart i nattetimene i går.

Med 1080x1200 per øye og noe under ~60% av dette arealet innenfor den skarpeste delen av synsfeltet vil oppløsningen føles lav. Jeg gleder meg til denne delen blir sammenlignbar med skjermer på 2560x1440, dvs. det blir over 4K-oppløsning per øye totalt.

-

Jeg ser ikke store problemer med prisen, så lenge den står i samsvar med kvaliteten. Det er tross alt snakk om et nisjeprodukt. Jeg synest godt de kunne laget en ennå dyrere og bedre modell, 10-12k for en del høyere oppløsning hadde jeg ikke sett noen problemer med.

Jeg kommer nok til å vente et par generasjoner før jeg kjøper ett eksemplar, helst til oppløsningen er høy nok til å matche 1440p i pikseltetthet i skarpdelen av synsfeltet. Om noen år skal jeg nok bygge meg en liten cockpit som den skal brukes i...

-

Siden du har bevist at du mangler helt elementær kunnskap om 3D-grafikk og visualisering så kan jeg bare råde deg til å lese noen gode bøker og skaffe deg erfaring. Å ty til utskjelling av andre er et kjennetegn på manglende seriøsitet.

-

Jeg tror du bør tenke deg om før du skjeller ut andre når du selv har bevist at du ikke besitter grunnleggende kunnskap om 3D-grafikk og visualisering.Å herligfred.

Du må seriøst ta deg en bolle for du har ikke peiling overhodet.

...

Slutt å uttal deg om noe du ikke har peiling på!

Her får du blankt stryk! FoV bestemmes av det enkelte spills projeksjonsmatrise, det er slik alle moderne GPUer tegner grafikk! Derfor kan du aldri påstå at Oculus Rift ikke har forvrengninger, fordi det er utenfor dens kontroll. Hvis ulike VR-briller får ulike linser så må spill tilpasses hvert enkelt for å unngå forvrenginger. Dette er 100% fakta og handler om forståelse av geometri.I riften har man ikke forvrengninger, fordi linsene gir en brennvidde/fov som tilsvarer virkeligheten og man får derfor ingen forvrengninger!!

Det du blander inn her er kroppens balanseorgan i ørene, som naturligvis er en utfordring med all visualisering. Men høyere skjermfrekvens gjør ikke noe til eller fra her.Man blir dårlig når man snur blikket med musen og ikke hodet, fordi hjernen ser at virkeligheten snur seg uten at man har beveget hodet og da gjør hjernen deg dårlig for at du skal slutte med det du holder på med fordi hjernen tror det er farlig.

Hvis du hadde kunnet dette så hadde du skilt mellom 3D og stereoskopi (som du egentlig snakker om her). VR-briller tillater ganske korrekt stereoskopi, noe en TV eller kino aldri kan klare. Men det betyr at steroskopifaktoren må være ganske lav, dvs. når spillet setter opp projeksjonsmatrisene så lager den to matriser plassert i øyeavstand fra hverandre. Hvis vinklingen der er overdreven for å skape en mer imponerende effekt så får du nøyaktig samme problem som med en del stereoskopiske filmer.Dette har ingen verdens ting med 3D-en man ser på TV og kino.

-

1

1

-

-

Det er ikke en eneste "påstand" i mitt innlegg, bare oppsummering av fakta. Naturligvis kan fakta være hardt å svelge for den del. For de som ikke har lest lenkene mine fra før så har jeg oppdatert med en rekke av de.

-

3

3

-

-

Alle 3D-spill setter opp det som kalles en projeksjonsmatrise som representerer 3D-rommet som skal rasteriseres ned på skjermen din. To av parametrene som brukes for å generere denne er vertikal og horisontal FoV(Field of View). F.eks. når du sitter fremfor en bestemt skjerm så skal FoV korrespondere med en rett linje fra hodet ditt til hvert hjørne i skjermen; som om skjermen er et vindu ut i verden. Siden det finnes skjermer i ulike proporsjoner, så bør FoV dynamisk justeres.Og hva mener du er for bedre synsfelt til denne type bruk? De fleste spill har vesentlig smalere synsfelt enn det man ser med et heldekkende synsfelt.

En rekke spill som førstepersons skytespill bruker gjerne overdreven horisontal FoV siden skjermpaneler ikke er omkransende nok, naturligvis. Dette øker altså synsfeltet men går på bekostning av forvrengninger. I noen spill kan du f.eks. se at objekter endre fasong når du vipper kamera opp og ned. Som du åpenbart forstår så skal geometrien ideelt sett representeres likt når du snur på kamera. En "feil" oppsatt projeksjonsmatrise vil altså fungere litt som et par briller som kan gi forvrenginger.

Som du forstår så er der store begrensninger i flate skjermpaneler, og ideelt sett så skulle de vært krummet både vertikalt og horisontalt. Det er nettopp dette VR-briller prøver å løse. Men da må også det enkelte spills projeksjonsmatrise være tilpasset linsene i VR-brillene. Så når Oculus, HTC, Samsung og flere kommer med slike produkter så må de enten bruke samme linser eller at spillene må tilpasses hvert produkt, dersom vi ønsker at det skal bli minst mulig ubehag selvsagt;)

-

Kompilator-infrastrukturen er åpen, så hvem som helst kan bruke dette for å kompilere CUDA til sin GPU-arkitektur.Cuda kompilatoren er ikke åpen for Gpu'er

Glem ikke at Nvidia er en av de store bidragsyterne bak OpenCL. Uansett ligger OpenCL årevis bak, og at noe CUDA-kode kan konverteres til OpenCL betyr ikke at det vil yte i nærheten av så bra. CUDA vil nok alltid ligge et godt stykke foran, og det er bare bra at AMD omsider ønsker å støtte noe av det. For den funksjonaliteten som AMD har støtte for så vil CUDA kompilert til GCN kunne yte ganske bra. Svært mye av CUDA er ganske generisk, det er ikke et lavnivå maskinkodespråk.Den andre artikkelen din er forresten datert fra 2008 og man kan jo spørre seg om det er snakk om samme situasjon i dag , en ting er sikkert Amd har i alle fall lagt til rette for at man enkelt kan portere Cuda kode over til OpenCl som igjen er en åpen standard.

Her kommer du med feilopplysninger som jeg har korrigert deg på en rekke ganger. Det er AdaptiveSync som er den åpne standarden, "FreeSync" er en proprietær implementasjon og en merkevare fra AMD. G-Sync for laptoper er AdaptiveSync markedsført som G-Sync.Amd kom også med sin implementering av Freesync som kan sammenlignes med Nvidia sin hardware baserte G-sync , Freesync er en åpen standard som betyr at hver og en som ønsker det kan implementere det i sine skjermkort , men selve kildekoden som Amd selv bruker er ikke tilgjengelig.

Du får mene hva du vil, jeg bare forholder meg til alle de fakta jeg har tilgang på.Finnes også flere ting man kan sette fingeren på hvor Amd faktisk har kommet med en åpen løsning , uansett så mener jeg at du tar grundig feil på disse punktene.

En rekke av dere AMD-fans elsker å fremstille AMD som en forskjemper av åpne standarder og Nvidia som en stor stygg ulv. Verden er ikke så sort-hvitt som du forsøker å fremstille den. Men faktum er at både AMD, Intel og Nvidia har sine sine åpne initiativer og sine "mørke" sider. Både AMD og Nvidia er skyldige i å "gå til sengs" med enkelte spillutviklere og lage spesialpatcher, i første pulje med Direct3D 12-spill ser det ut som at AMD har jobbet hardest med dette. Vi må aldri glemme at alle tre er selskaper som skal tjene penger. Og når vi ser på det store bildet så kommer faktisk Nvidia noe bedre ut, med noen initiativer:

- Nvidia er hovedarkitekt bak OpenGL siden versjon 3, uten de hadde vi ikke hatt noe moderne OpenGL. Nvidia er også suverent raskest til å implementere OpenGL.

- Akselerert videoavspilling gjennom VDPAU, som også brukes av "åpne" drivere.

- Native GPU-API(i likhet med AMD), åpen driverinstallasjon og GPU-konfigurasjon for Linux.

- En åpen Tegra-driver.

- Åpen CUDA-kompilator.

- Deler av PhysX er tilgjengelig.

- GLVND så sent som i går.

og en del mer.

AMD har på sin side påstått at Mantle skulle være åpent, men det var dødt lenge før det kom så langt. FreeSync påstår de er åpent eller gratis (de klarer aldri å bestemme seg!), men det er AdaptiveSync som er åpent og er ikke laget av AMD. Så det beste eksempelet jeg kommer på er noen effekt-biblioteker som AMD har laget som er åpne, samt AMDs native API ADL.

-

1

1

-

-

Leste du hele innlegget? Gikk du kanskje glipp av det jeg sa med strobeeffekt og transparent grid?Det generelle problemet med VR-briller er at forvrengning gjør folk svimmel, skjermfrekvens og latency vil gjøre lite med det. Hvis en VR-brille og tilhørende spill har samme projeksjon som brukeren vil se i den virkelige verden så skulle ikke det lenger være et problem.

Naturligvis vil alltid ekstreme bevegelser være ubehagelig, men det er det også i virkeligheten, så det har fint lite med VR-brillene å gjøre.

Og økningen til 90hz hjelper faktisk mye, tror du nok burde lese litt mer om dette før du uttaler deg slik.

Lav frekvens og høy latency er ekstremt sjøsykefremkallende. Ekstremt!

Jo smoothere motion, jo mindre sickness. Hvis du har prøvd et Oculus headsett før, så vet du dette allerede.

Hvis et spill har judder eller lav fps blir man mye dårligere enn om det kjører mykt og fint.

Forvrengning har aldri vært et problem. Forvrengning korrigeres for i driverne og alt man får i HMD-en er et rektilineært perspektiv, eller hvertfall tilnærmet rektilineært

Som sagt er ikke skjermfrekvens et stort problem, så godt som alle filmer er i 24 Hz og TV-serier i 24-25 Hz, det har aldri vært et problem som har gjort folk svimmel, bare et irritasjonsmoment pga. merkbar hakking.

Problemet med VR-briller skyldes to ting:

- Overdreven stereoskopisk effekt. Her har VR-briller akkurat samme problem som stereoskopisk TV og kino har hatt i alle år; at effekten overdrives og blir plagsomt for synet. Faktum er at den stereoskopiske komponenten av dybdesynet begynner å bli svært ubetydelig på litt over en 1m avstand, som gjør at realistisk stereoskopi skal tilnærmet ingen effekt på det meste som vises på skjermen. Hvis dette hadde blitt brukt korrekt så hadde ikke folk sett hensikten med steroskopi, så produsentene overdriver effekten for at den skal bli merkbar. Dermed blir også folk svimmle og kvalme.

- Feil projektsjon: dette er primært spillutviklernes feil. Svært mange spill har for bredt synsfelt som medfører forvrenginger når kamera snus. Dette er også et problem for konvensjonelle skjermer, men kan bli betydelig forverret hvis det ikke er spesialtilpasset linsene på de enkelte VR-briller.

FEATURE: Slik gikk det da jeg dro på mutantjakt i Tsjernobyl i 1989 (Ekstra)

i Diskuter artikler (Tek.no)

Skrevet

Naturligvis er mye av det som har vært sagt rundt Tsjernobyl-ulykken vært overdrevet og oppdiktet av mediehysteriet. Det er helt vanlig at media overdriver ekstra når der er mangel på informasjon, og gir oppmerksomhet til ganske ville rykter.

Likevel reagerer jeg på et par ting i denne artikkelen:

Samt anekdoter om et par dyr. Saken er at alle slike anekdoter er verdiløse og ganske enkelt farlige. Skal du vise om noe er har en innvirkning eller ikke så må du sammenligne et utvalg med et utvalg fra en annen tilsvarende befolkning/bestand/osv. Mutasjoner skjer overalt i naturen, men her handler det om å påvise signifikante økninger i mutasjoner, kreft, osv. Selv om langt flere har tatt skade av frykten så betyr ikke det at folk ikke har fått alvorlige skader av denne ulykken.