efikkan

-

Innlegg

24 979 -

Ble med

-

Besøkte siden sist

-

Dager vunnet

1

Innholdstype

Profiler

Forum

Hendelser

Blogger

Om forumet

Innlegg skrevet av efikkan

-

-

Du bør nok planlegge at den skal byttes snart, stabilitet til strømforsyningen påvirker levetiden til komponentene.

-

Vel jeg kan ta tak i noen av problemene her

Arrayet

For det første, når du skal ha et array hvor størrelsen bestemmes under kjøring så må du gjøre noe aktivt for å allokere arrayet:

float n[10];

Dette gir et array med 10 elementer, hvor første element er n[0] og siste element er n[9].

Én måte å allokere arrayet på er med calloc:

float *n = (float*)calloc(N, sizeof(float));

Merk at n er nå en peker til arrayet, og at du skal frigjøre minnet når du er ferdig med arrayet:

free(n);

Løkken

Det neste du bør se på er å fikse selve løkken:

for (float i = A ; i<=B ; i=A+T)

Hvis du ser hva i settes til i siste del så vil du se at denne løkken vil iterere uendelig.

Jeg antar at du ønsker å gjøre noe sånt:

for (float i = A ; i<=B ; i+=T)

Jeg har lagt ved en fil som har gjort disse endringene og som vil kjøre. Nå kan ikke jeg garantere at det løser oppgaven, og logikken i koden din er ellers uendret.

I tillegg så er der en rekke småpirk som kan påpekes:

Variabelnavn

I C er det vanligst å skrive variabelnavn på følgende måte: min_fantastiske_variabel, som kalles underscore. Mange foretrekker derimot camelCase som vil se ut som minFantastiskeVariabel; Uavhengig av hva du velger så bør du være konsekvent så du ikke har noen variabler med liten forbokstav og andre med stor. Du bør også unngå to variabler som heter det samme hvor den ene har stor forbokstav og anden andre har liten, det gir svært forvirrende kode (eksempel n og N i koden din).

Whitespace, indentering og newline

Du bør være konsekvent på bruken av whitespace, indentering og newline. Her finnes det også et hav av konvensjoner, og så lenge du koder for deg selv så kan du finne din egen. Men husk at det er svært irriterende for andre å lese kode som er inkonsekvent. Jeg anbefaler å bruke whitespace til indentering, siden tabs kan representeres ulikt. Det ser også best ut om du noen gang skal bruke git eller lignende. Hvor mange whitespaces som brukes kan diskuteres, både 2, 4 og 8 er vanlig, selv om 4 trolig er det mest vanlige (f.eks. Linux-kjernen bruker derimot 8). Du bør også velge hvordan du bruker whitespace rundt operatorer(=, <=, ==, +=, osv.) og paranteser. Angående newline så bør du også velge et prinsipp. Jeg ser f.eks. at du har newline for bracket inne i for-løkken men at neste statement fortsetter på samme linje som bracket.

Jeg kunne fortalt mye mer om koden i detalj, men det er grenser for hva folk klarer å forstå umiddelbart. Nå vet ikke jeg om dette er en skoleoppgave eller lignende, men du må gjerne spørre etter mer hjelp og forklaringer her på forumet. Du får sannsynligvis mer hjelp av dyktige kodere her enn fra skolen.

-

1

1

-

-

Ja, det er ikke uten grunn at jeg (og sikkert mange andre her) har mer enn én PC og tar i tillegg vare på litt gamle deler. Noen ukers tid uten PC er nemlig ikke holdbart.

-

2

2

-

-

Du kan prøve å starte opp, men det er ingen garanti for at det går. Hvis det ikke er nok så blir skjermbildet sort eller en feilmelding før boot.

Har du forøvrig et par frie 4-pin molex-plugger? Normalt følger der med en overgang fra 2x4pin til 1x6pin.

Hvor bor i landet bor du eventuelt?

-

Leveringstiden til CDON er vel antall dager før de estimerer at varen er sendt, CDON opererer med ulike grossister.

Uansett så har jeg sluttet med å kjøpe PC-deler fra CDON, de få kronene spart er ikke verdt styret.

-

Slapp av, jeg er motstander av all slik hysteri. Naturen er full nok av farlig kjemi. Stråling også. Radon er 100% naturlig og likevel veldig farlig.

Det er helt klart at redusert stress, frisk luft, daglig mosjon, hjemmelaget mat og utkutting av røyk, snus og alkohol er rasjonelle valg som har stor innvirkning på helse. Men de som tilstreber å "leve i pakt med naturen" går som regel over i en ideologisk verden der alt "naturlig" blir ansett som bra og alt "kunstig"/"kjemisk" blir ansett som farlig. Når folk gjør slike irrasjonelle valg så kan ting bli direkte farlig, enten det er vaksinemotstand, "naturmedisin", osv...Gir man i tillegg opp det hektiske og altoppslukende arbeidslivet, flytter ut i skogen og starter et enklere liv i pakt med naturen hvor ingen snarveier er lov, ikke en gang mikrobølgemat, så vil nok de fleste føle seg sunnere og friskere etter ei stund.

Jeg tror jaggu naturen har masse helt naturlig elektromagnetisk stråling å by på også. Solstormer, for eksempel. De er kraftige nok til å påvirker satelitter og mye av det elektroniske utstyret vi bruker, i sterke tilfeller også helt nede på jordoverflata. Solstormer har slått ut telegraf-linjer og strømtrafoer. Noen som vet hvor sterk strålingen fra en kraftig solstorm er, sammenlignet med for eksempel stråling fra mobilmaster?

Vi bombarderes konstant av kosmisk bakgrunnsstråling også, og du utsettes faktisk mye mer for dette om du bor ute i naturen enn inne i trygge hus.

Og for å si det sånn, stråling fra mobiltelefoner er helt insignifikant i forhold til kildene du nevner

-

Det er helt klart at redusert stress, frisk luft, daglig mosjon, hjemmelaget mat og utkutting av røyk, snus og alkohol er rasjonelle valg som har stor innvirkning på helse. Men de som tilstreber å "leve i pakt med naturen" går som regel over i en ideologisk verden der alt "naturlig" blir ansett som bra og alt "kunstig"/"kjemisk" blir ansett som farlig. Når folk gjør slike irrasjonelle valg så kan ting bli direkte farlig, enten det er vaksinemotstand, "naturmedisin", osv...Gir man i tillegg opp det hektiske og altoppslukende arbeidslivet, flytter ut i skogen og starter et enklere liv i pakt med naturen hvor ingen snarveier er lov, ikke en gang mikrobølgemat, så vil nok de fleste føle seg sunnere og friskere etter ei stund.

-

3

3

-

-

Det nærmeste vil vel være eksempler der folk har blitt "syke" av mobilmaster som ikke er påslått.Den store akilles'en med dette er at jeg vet jeg er i en test i utgangspunktet. Kan det rigges uten at jeg vet jeg er i en test?

-

Alt du trenger er en avslått og en påslått telefon i en blindtest. En telefon avgir bare et par watt i alle retninger, så telefonen står ikke for noen merkbar oppvarming. Du blir varm om du holder hånden mot hodet over tid.En utfordring er hvordan få satt en barriere mellom hode og telefon, så du ikke er klar over at telefonen er der, men like fullt ut ha millimeter med avstand fra normalbruksstilling?

Apparatet bør varmes opp slik at man ikke kjenner den varmestrålingen det avgir/stjeler når det kommer millimeter fra øret.

-

1

1

-

-

Folk har selvsagt rett til å kaste bort penger på det de selv ønsker, men problemet er når noen bevisst utnytter noen i en vanskelig situasjon. De som velger å omlegge livet sitt for "eloverfølsomhet" påføres både en stor økonomisk belastning og potensielt isolasjon fra samfunnet. Det er spesielt ille når noen påfører en slik belastning på sine nærmeste, spesielt barn. I tillegg presses noen arbeidsgivere til å tilrettelegge for fiktive plager på arbeidsplasser, og det blir dermed et problem for samfunnet.Ja, dei har funne ein måte å leve med det på, og det kan sikkert i nokre tilfelle vere fornuftig å legge til rette for dei, enn så lenge det ikkje er for kostbart eller at sjukdommen berre blir verre etter kvart.

Folk som hevder å være "eloverfølsomme" faller i én eller begge av følgende kategorier:

1) Fiktive plager

2) Andre diffuse plager som er urelatert til elektromagnetisme

For de som er berørt av (2) blir det dermed svært destruktivt at de får en bevisst feildiagnose (for at de skal holde kjeft), når de egentlig trenger annen hjelp.

Jeg har full forståelse for at de som har reelle plager kan bli desperate i søken etter hjelp, og derfor søker alternative forklaringer og hjelpemidler. Jeg vet utmerket godt hvordan det er å leve med kroniske smerter.

Det er en vitenskaplig umulighet at noen kan kjenne signalet fra en telefon, samme hvilken årsmodell det er snakk om.Ellers har du noen gode poeng i å besvare mitt innlegg. Jeg skal ikke påstå at jeg klarer å gjenkjenne en 80-talls håndfri hustelefon når jeg ikke vet at den er der. Men, det hadde vært gøy å prøvd det ut. Er ellers fullt klar over at nocebo har innvirkning på folk. Og jeg er hellig overbevist om at folk kan framprovosere på meg nocebo også. Men, likevel så kunne det vært interessant å ha testet den strålingsfølsomheten der vitenskapelig..

Én av flere kilder til folks overtro om stråling er at en rekke elektriske apparater sender ut høyfrekvent støy (lydbølger, ikke "elektrosmog") som gjerne kan være nær grensen til hva som kan høres. Eksempler på slikt er strømforsyninger/ladere, skjermer, TVer, kjøleskap, bærbare PCer og til og med sparepærer. Slike ting kan naturligvis være plagsomt og forårsake hodepine, så mange som ikke vet bedre kan tro at dette er elektromagnetisk stråling. Og ja, slik støy kan brukes til å lokalisere gjenstander.

-

1

1

-

-

Hysteriet rundt "eloverfølsomhet" er fremdrevet av en stadig voksende "alternativbransje". Enten det er snakk om "el-overfølsomhet", homøopati, vaksinemotstand, akupunktur, "jording", "detox-kur", økologisk/biodynamisk mat, kiroprakti/osteopati/naprapati, urtemedisin, gestaltterapi, diverse alternative dietter og mye mer har alle til felles at de er basert på overtro, mystikk og i noen tilfeller konspirasjonsteorier.

Folk er mer overtroiske enn noen gang, og en rekke av overnevnte har blitt allment akseptert på tross av at det er påvist at det er lureri. Flere av disse har til og med funnet veien inn i skolebøker som "sunne" og "miljøriktige" alternative livsstiler. Noe så enkelt som "el-overfølsomhet" er noe enhver som har hatt fysikk på skolen vet er bare tull, men likevel er overtroen så sterk i befolkningen at tullinger har fått gjennomslag for å legge om kraftlinjer og flytte lekeplasser. Jeg vet om flere eksempler på dette fra området jeg har vokst opp.

Alternativbransjen er i dag "big business", og er mer lukrativt enn noen gang. Behandlingsklinikker har dukket opp i snart alle bygder og byer, og et stort utvalg av alternativ "medisin" og mat er i alle matbutikker. Dessverre har også flere alternative behandlingsformer blitt offentlig godkjente behandlingsformer i en rekke land, og det sløses dessverre bort mengder av skattepenger på slikt. En rekke barnehager og skoler har kastet seg på alternativ-bølgen, og ikke bare dedikerte alternativ-miljøer slik som antroposofer og lignende. Et av de klareste eksemplene på denne svindelbransjen er butikken Unovita i Oslo, som blant annet selger beskyttelse mot stråling, revitalisering av vann og mye mer. Det er også bred støtte både politisk og kjendismessig; Brundtland, Støre, Almaas, Schiøtz og mange flere.

Argumentet som brukes igjen og igjen er at "vi ikke vet nok om stråling", på tross av at elektromagnetisme er et svært godt utforsket område. Den som graver klarer å finne én og annen undersøkelse som antyder problemer, men folk glemmer det mest grunnleggende prinsipp i vitenskapen; resultater skal være reproduserbare gang på gang. Derfor vil vi alltid fra tid til annen høre om "forskning viser at x er farlig", og så blir det tilbakevist.

Angående sitatene til Bruntland;Jeg kan ikke ha mobilstrålene her oppe. Da får jeg øyeblikkelig hodepine. Min kropp har reagert på mobilstråling i 25 år

Dette ville vært lett å teste.

Det finnes jo folk som har fått brannsår på brystet fordi de har mobiltelefonen i skjortelommen.

Det finnes folk som har fått skader av overopphetede telefoner ja, men det har ingen verdens ting med stråling å gjøre. Hvordan kan folk få seg til å tro at en mobiltelefon på under 2W kan gi brannsår av "stråling" mens de tør eie en komfyr? Dette blir bare dummere enn å tro på Julenissen.

Jeg kan også identifisere mobiltelefoner i et rom, uten å se dem

Her har nok "landsmoderen" kvalifisert seg til en innleggelse.

Det er forøvrig interessant at de "beste" talspersonene for "eloverfølsomme" er disse to skruene Halmøy og Oddekalv. Halmøy som tidligere har profitert på "eloverfølsomhet", i tillegg til nu skin og annen pyramidevirksomhet. Oddekalv er heller ikke kjent for å være spesielt troverdig.

Det er ikke vanskelig å finne eksempler på hvor tvilsom denne bransjen er:

(legg forøvrig merke til okkult symbolik og ordbruk)

-----

Jeg er ikke spesiellt plaget av denne påståtte overfølsomheten. Likevel så har jeg ved noen anledninger opplevd litt av det. Det har selvsagt vært når jeg var bevisst bruken av apparat. Det er vel vesentlig å nevne.

Da vil du være enestående i verden som klarer å kjenne ikke-ioniserende elektromagnetisk stråling.

Hva er galt med selverklært.

Fordi kroppen er svært dårlig til å bedømme sin egen tilstand. Selv de beste leger oppsøker andre leger for en objektiv diagnose.

Da vil ikke legen kunne si noe annet enn det du forteller at du opplever om den saken. Så selverklært er vel ikke nødvendigvis noe negativt. I dette tilfelle så kunne jo legen skrevet ut et medikament som var smertestillende, og pasienten får likevel hjelp.

Med de "følsomme" så må vel legen blande inn psykiatrien, slik at man kan lære seg å leve bedre med "fobien sin".Plagene som folk beskriver er utelukkende diffuse symptomer som kan komme av nesten hva som helst. Så langt har der ikke vært ett eneste påvist tilfelle av "eloverfølsomhet", og symptomene kan forklares som innbilte plager eller andre udiagnostiserte problemer.

husker at det var et oppstyr når wifi ble populært. det ble rapportert på nyhetene om at "alle" fikk hodepine og følte seg dårlig når de ble utsatt for wifi-et...

Og folk har blitt "syke" av mobilmaster som ikke har vært tatt i bruk også. Merkverdig at folk trenger å vite om "strålingskilden" for å bli syke

-

4

4

-

-

Det eneste "interessante" er mulighet for flere kjerner, så nesten alle CPUer på E-plattformen vil forbli gode.Blir da ganske nøyaktig 2 år etter Haswell-E det da. 5960X vil fortsatt være en knallgod CPU

Min i7-3930K er det beste kjøpet jeg noen gang har gjort.

-

Broadwell-E skulle komme i Q1 men ble utsatt til Q2.

Siste ryktene jeg så var at det kommer Q1 eller eventuelt ikke i det hele tatt og skylake-E kommer Q3, finnes det nyere rykter?Broadwell-E for konsumermarkedet blir lansert mot slutten av andre kvartal i år.

-

Den krangelen der er vel litt en definisjonssak om hva som menes med hvem som gjør selve "utviklingen". AMD og Nvidia har fremmet sine ønsker om minneteknologi, og så har minneprodusentene laget prototyper som skal svare på de ønskene. GPU-produsentene har kommet med tilbakemeldinger og gjort testimplementasjoner, men de har ikke stått for tegningen av DRAM-brikkene. Så selv om GPU-produsentene er med i utviklingsprosessen så er det ikke de som har æren for utformingen av kretsene.

Det meste TKongen sier forøvrig er korrekt.

-

2

2

-

-

intel har ingen konkurranse.... derfor dem konsekvent øker ytelse med 12-13% hver generasjon prosessor... det er en kontrollert redusert økning....

12-13% for hver generasjon? Da lurer jeg på hva du måler, for i generell ytelse så har vi ikke sett såpass stor forbedring per generasjon fra Sandy Bridge til Skylake.

Hva er vitsen? Ser vi siden:

i5 2500K - i5 3570k - i5 4670k (i5 4690k) så i5 6600k

i7 2600k - i7 3770k - i5 4770k (i7 4790k) så i7 6700k

Siden du er vel enig har man i5 2500k oppgrader man ikke til i5 6600k

Samme når det gjelder i7 2600k til i7 6700k.

Muligens EU direktive har samme krav som lyspærer å forby å selge nye cpuer som trekker mye strøm sammenlignet mot morderne løsninger. Halogen vs LED.

Blir samme som i7 6700k vs i7 2700k.

For min del skal intel komme med noe nytt bør de helle satse på 8-16 kjerner eller finne løsninger som gjør cpuene kan overklokkes bedre.

Ja, som du ser så har ytelsen per kjerne vært stagnert siden Sandy Bridge, så eneste gode grunn for å oppgradere er ønsket om flere kjerner.

Hvem ville ikke hatt i7 6700k med turboboost til 6 ghz? Som eksempel?

Eller hatt hypetreading med 4x tråder?

Selv om det finnes last hvor fire threads per kjerne hadde vært nyttig, så er det svært få kjøpere i dette segmentet som har bruk for det. Problemet med i7-6700K er at hovedforskjellen over i5-6600K er HT, og om du trenger HT så har du ennå mer bruk for flere kjerner. Derfor er i7-5820K til noen hundrelapper mer et suverent bedre kjøp, og i7-6700K(og tilsvarende forgjengere) ender opp som et av de klart dårligste kjøpene i hele sortimentet.

Ja, de Intel-svina skulle bare ha satt all utvikling på vent i 2-3 år så AMD kunne ha tatt dem igjen...

Sarkasme regner jeg med.

Og norske skiløpere burde tatt et par års treningspause i sympati for andre...

-

Du har vel et gammelt skjermkort liggende? (eller hva du nå bruker)Jeg kommer ihvertfall til å vente. Selv om jeg måtte trøste meg på Intel intern grafikk i ventetiden

(typisk i5 eller i7 CPU), dersom jeg fristes til å gjøre et selvbygg i ventetiden.

(typisk i5 eller i7 CPU), dersom jeg fristes til å gjøre et selvbygg i ventetiden.Integrert grafikk er tragisk...

-

Hvis produksjonen skulle startet ved utgangen av andre kvartal så hadde produktene ikke blitt klare før nærmere jul. Både Nvidias og AMDs brikker er allerede i produksjon.Digitimes mener videre å vite at Nvidia vil starte masseproduksjon av brikkene som kan bli en del av «GTX 1000-serien» før utgangen av første halvår.

-

Nettopp, alle som har to eller flere disker i RAID har bruk for mer enn 1 Gb/s.

Nå bør du tenke deg om på tallene her. Én enkelt disk klarer da å levere mer enn 1Gb/s ethernet kan overføre.CPU har jo fint lite å si på om du klarer å dytte 10G. Det lille du nevner av disker tilsier at du ikke er i nærheten av å trenge 10G.

Det er forsåvidt også sant - jeg har 10Gbit her, og selv om jeg ikke trenger 10, bruker jeg rutinemessig mer enn 1 Gbit. (Jeg hadde klart meg lenge med 4Gbit, men fant noen pent brukte fiberkort på finn, så ...)

Nei, det heter Solid State Drive.Solid State Disk

Solid State Disk vil være en direkte selvmotsigelse.

-

1

1

-

-

Nå bør du tenke deg om på tallene her. Én enkelt disk klarer da å levere mer enn 1Gb/s ethernet kan overføre.CPU har jo fint lite å si på om du klarer å dytte 10G. Det lille du nevner av disker tilsier at du ikke er i nærheten av å trenge 10G.

-

Litt på sidelinjen, så ser det ut til at det snart skjer noe mer på 10G-fronten.

-

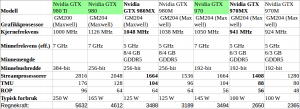

Her er en liten oversikt hvor jeg har satt inn relevante desktop-GPUer:Men er det slutt på den tiden (Laptop gir dårligere ytelse en stasjonær?)

Så hvis vi sammenlignet:

GTX 970 (Stock versjon) vs Nvidia GTX 970MX

GTX 980 (Stock versjonen) vs Nvidia GTX 980MX

Stock versjonen mener jeg ikke fabrikkoverklokket.

Så skal det være umulig å merke forskjellig i spilling, med mindre laptop produsentene har satt tempratur\sperre i bios?

Med tanke på batteridrift\skjermkort bruk.

Nå er jeg usikker på slike laptop skjermkort kan overklokkes.

Dette vil i så fall være bra for gammere, men syns særlig delen for skjermkort med lav strømbruk er nvidia dårlig.

Som du ser er GTX 980MX fremdeles litt svakere enn GTX 970. GTX 980Ti er ~60% raskere. Så det er fremdeles ikke slutt på det store ytelsegapet mellom laptop og desktop, og det kommer til å vedvare i minst 5 år til. I tillegg har laptoper svakere CPUer.

Skjermkort i laptoper kan overklokkes, men smart er det ikke.

-

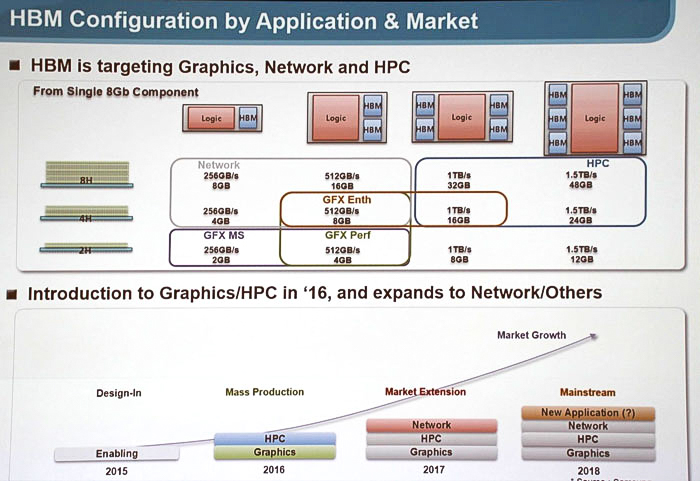

Jeg forventer HBM2 på "big pascal" ("GP100"?), om det kommer på den nest største brikken er usikkert.Men betyr det man kan forvente seg High Bandwidth Memory 2 i GTX 1080?

Eller må det blir Fremtig etterkommer av GeForce GTX TITAN Z\Titan X?

Men for deg som kjøper burde det ikke være et problem, for du bør velge skjermkort etter prestasjoner i forhold til dine krav.

Jeg kan ikke fatte hvorfor R9 380X skulle være et mer fornuftig valg enn GTX 970. Du får kjøpe skjermkort når du har for svak ytelse, og da bør du gjerne kjøpe noe som er en god del bedre enn det du har for at det skal holde en stund.Fikk lyst på nyere skjermkort en GTX 770, GTX 970 er ikke så stor oppgradering her, og GTX 980 TI er bortkastet når det snart kommer nyere, Så blir vel over på R9 380x som er eneste fornuftige i dag.

-----

Edit: leste feil.

Definitivt.Kanskje HBM kommer i nvidia Tesla for workstation?

-

Det er heller ingen som ønsker det. Jeg bare påpeker hvorfor de to andre sliter med å holde følge med Nvidia. Som du ser er det opptil 72x forbedring i ytelse per watt. Hvis du tenker deg om så vet du at dette er høyere enn den teoretiske forbedringen mellom generasjonene, så OpenGL på Maxwell klarer altså å utnytte maskinvaren betydelig bedre. Det er også verdt å nevne at selv med GeForce 8-serien var Nvidia best på OpenGL den gangen, så de andre vil trenge en ennå større progresjon for å ta igjen Nvidia.Om nvidia blir enerådende kan ikke være gledelig for andre enn pappskaller.

Jeg påpeker dette fordi OpenGL burde vært en god investering for AMD med sin bunnskrapte kasse, for hadde de fikset opp driverne sine så hadde produktene blitt aktuelle for mange profesjonelle og semiprofesjonelle brukere. Det er ille når GTX 950 kan slå R9 Fury i nyere OpenGL-spill, selv om vi vet at R9 Fury teoretisk sett er mye kraftigere.

Ja, det blir for skjermkort/compute-kort i første omgang.Noen som vet angåenende:

High Bandwidth Memory 2

Samsung lover mye raskere dataminne – allerede nå

Blir dette for AMD\Nvidia Skjermkort?

-

2

2

-

-

Og her ser dere hvorfor ingenting kan matche Nvidia på det området:

OpenGL Performance & Performance-Per-Watt For NVIDIA GPUs From The Past 10 Years.

KOMMENTAR: – HDR er den største nyheten siden TV-en fikk farger

i Diskuter dataartikler (Tek.no)

Skrevet

Fenomenet HDR er absolutt ikke nytt, men den store nyheten her er at HDR blir et distribusjonsformat som av noen få paneler skal vises native.

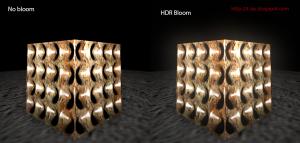

Fra før av har vi to typer generering av HDR-bilder. Dere som driver med foto er nok godt kjent med HDR som en funksjon som kombinerer bilder av ulik eksponering og deretter konverteres til et bilde som ser omtrent slik ut:

(bilder stjelt fra Wikipedia og diverse andre sider)

Kvaliteten på HDR-bilder er naturligvis avhengig av råbildene som blir tatt, hvordan disse kombineres til ett HDR-bilde og til slutt hvordan HDR-bildet faktisk vises. Sistnevnte er det største problemet som ikke har vært løst før nå, og er nettopp det den nye HDR-standarden for UHDTV dreier seg om. For saken er at når du har et HDR-bilde så kan ikke en normal skjerm vise det, så det konverteres med noe som kalles tone mapping som konverterer bildet til "SDR" og forsøker å bevare kontrast så pikslene sin nye lysstyrke maksimeres i forhold til regionen rundt. Detaljene i konturer bevares på bekostning av de fleste øvrige aspekter av bildekvalitet.

Og det er nettopp her at HDR-bilder blir "stygge" og "urealistiske". Områder som er veldig lyssterke blir uskarpe(1), skygger forsvinner i stor grad(2), og en rekke konturer i flater(3) overdrives ekstremt. Hvis du har en mørk stjernehimmel med lyssterke stjerner så blir områdene rundt stjernene opplyst. Lyssterke områder ser nesten ut til å "gløde".

Dette gjør at mange bilder ser litt "tegneserieaktig" ut:

Den andre måte HDR-bilder kan genereres på er i spill og simulatorer. Og dette har vi allerede hatt siden DirectX 9.0c og OpenGL 1.4, og har vært vanlig i spill i et tiår. Fordelen her er at selve HDR-bildet kan genereres rimelig perfekt, i motsetning til alle utfordringene som oppstår for et kamera som skal ta bilder til et HDR-bilde. På tilsvarende vis konverteres dette HDR-bildet til et ferdig bilde med en form for tone mapping, som oftest kalles for "HDR/bloom" i spill. Ulempene med denne konverteringen er i stor grad den samme som med bilder fra kamera, og som er grunnen til at en rekke spillere (meg inkl.) ofte ønsker å slå av HDR/bloom i spill fordi det er travelt å se på:

(flere eksempler)

Jeg ser frem til at vi får etablert en skikkelig standard for dette også på PC-skjermer. Men jeg ser for meg at de fleste skjermer og TVer som selges som HDR-kompatible i realiteten ikke er det, med tanke på begrensningene i LCD-teknologien som i realiteten ikke er i stand til å klare dette. Det blir nok en blanding av juksing med baklys og "tone mapping"-filtrering for å tilnærme seg standarden, men det burde være rimelig åpenbart for de fleste at bare OLED og andre fremtidige teknologier er i stand til å representere dette rimelig bra.

3DStereoskopi har sin hensikt, men effekten på dybdesynet er bare betydelig på svært kort avstand. Derfor har det nær ingen hensikt på TV eller kino. Filmer bruker å overdrive effekten for at du i det hele tatt skal se noe av den, som også er årsaken til at folk føler ubehag når de ser på det. Hvis du skal ha rett stereoskopi på TV/kino så blir effekten så marginal at den knapt merkes.For det andre så vil et lerret eller én skjerm som genererer et stereoskopis bilde aldri bli fritt for forvrengninger. Egentlig skal nemlig hvert øye ha sitt bilde normalt på, noe som er umulig å oppnå uten VR-briller, som forøvrig er det eneste stedet hvor stereoskopi gir noe mening.

Ja CRT hadde faktisk mer ikke-lineær lysstyrke som ligner noe mer på transferfunksjonen som brukes i "HDR" (Rec._2020), mens LCD-paneler har nesten linær lysstyrke fra "sort" til hvitt. De LCD-panelene som viser mørkere sort manipulerer baklyset gjennom lokal dimming, som introduserer stor lokal fargefeil.

Med glede

- På en typisk LCD-skjerm vises RGB-verdier fra 0-255(8-bit) tilnærmet lineært.

- På en "kalibrert" HDTV(Rec. 709) vises RGB-verdier 16-235/240(8-bit) som er linær i nedre del og eksponentiell i øvre del, men er likevel "nesten" linær i det meste av skalaen (du klarer ikke å se det så lett). Standarden har et definert fargerom(gamut) for "nøytralverdien" 128, selv om langt fra alle TVer er i nærheten av dette.

- På en "HDR" UHDTV(Rec._2020) gjøres flere ting:

- Utvidet fargerom, spesielt i grønnfarge som øyet er mest sensitivt for.

- Krever 10 eller 12 bits fargedybde som gir rom for flere graderinger mellom farger.

10-bit gir RGB-verdier 64-940

12-bit gir RGB-verdier 256-3760

- Krever høyere oppløsning

- Krever progrssive scan (altså ikke linjeflettet (fantastisk ord))

- "Transferfunksjonen"(SMPTE ST 2084) endres litt, dvs. konvertering fra RGB-verdier til lysstyrke. Nedre del er fremdeles lineær, så jeg er spent på hvor mye det merkes nær helt sort. Selv "avanserte" TV-kalibreringer bruker ikke å måle dette nøyaktig.

Nå har ikke jeg tatt bryet med å plotte funksjonen, men det sier seg selv at det som er "sort"(16) etter dagens standard blir et tall over 16 i den nye, og det som er "hvitt" i dag(235) blir et tall over 235. Vi vil altså trenge en konverteringsfunksjon for å vise eksisterende bilder som før.

I praksis skal altså "HDR" gi flere trinn mellom dagens 16-235 i RGB-verdier, samt noe over og noe under.

Ja, nettopp.

Nå er h.265 "dobbelt så effektiv", men 4K firedobler antall piksler og 12-bit HDR øker størrelsen av hver piksel med 50% på toppen av det. Riktig nok blir komprimeringen noe mer effektiv med høyere fargedybde. Du må regne med at streaming kommer til å kjøre dette med latterlig lav bitrate i mange år fremover.

En liten digresjon;

Folk vil nok innse at de milliardene med skattepenger som ble brukt på det digitale bakkenettet var en dårlig investering når hele nettet blir "utdatert" innen få år. Den båndbredden burde vært frigjort til mobil datatrafikk, og så de pengene heller brukt på sponsing av infrastrukur i fiber eller lignende.

10-bits LCD-paneler har eksistert i over 10 år, men de følger ikke denne nye standarden. Hvis du har to 10-bits grafikerpanel sidestilt og det ene opererer i 8-bits-modus og det andre i 10-bits-modus, så vil et 10-bits bilde på begge paneler vises med samme rekkevidde fra sort til hvitt, men 10-bits-panelet vil vise 4 ganger så mange graderinger mellom.

I tillegg har vi lenge hatt kamera som opererer med rådata-format i høyere enn 8-bit. Nøkkelen blir da hvordan dette konverteres til et distribusjonsformat, og det er her standarden for "HDR" for UHDTV endrer på ting. Jeg håper at vi snart får tilsvarende for PC-skjermer, slik at det blir relativt forutsigbart hvordan RGB-verdien x,y,z skal vises på en skjerm.

Jeg kan ikke fordra at selv dere journalister som jobber med AV omtaler LCD/Plasma/OLED som "flatskjerm" kontra CRT. Dere skal vite utmerket godt at det fantes flate CRT og bakprojeksjon i årevis før Plasma og LCD tok av på markedet. Det dere egentlig snakker om her er at LCD/Plasma/OLED er tynt, ikke flatt.

Og her må vi nok regne med at TV-produsentene kommer til å lage en "vivid"-modus som avviker fra standarden (som vanlig) for å overdrive forskjellene, og folk kommer til å kjøpe den TVen med de mest "glorete" fargene.