zlpw0ker

-

Innlegg

1 845 -

Ble med

-

Besøkte siden sist

Innholdstype

Profiler

Forum

Hendelser

Blogger

Om forumet

Innlegg skrevet av zlpw0ker

-

-

syar2003 skrev (5 minutter siden):

Er den sjette skjermen din klonet skjermbilde i adaptere etc eller er den et eget display ?

Du sier ikke noe om oppsettet ditt (hardware). Windows 10 støtter inntil 10 display native.Korrekt,den 6e skjermen kloner skjermbilde til skjerm nr5. Ingen skjermer koblet til noen adapter/HDMI spliiter, all direkte koblet til en video out. Alle bruker DP. De er også et eget display.

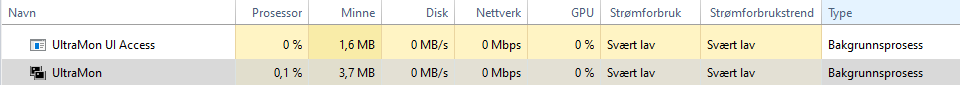

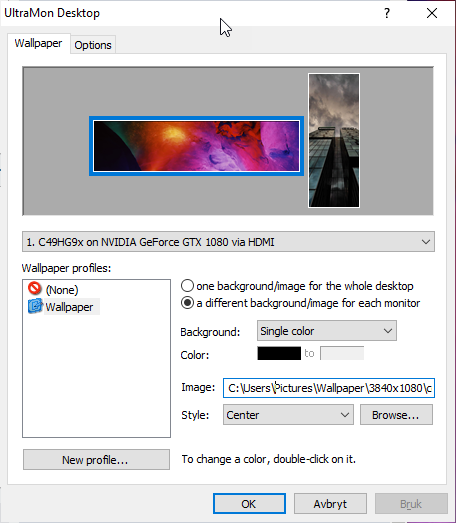

Oppsett:W10,2x 1080 GPU'er. Problemet er jo ikke støtten for 10 native monitorer, men heller muligheten for å ha et bilde i hver skjerm. i settings-->background til hver skjerm. Hadde det bare vært mulighet for å øke med mer enn 5 skjermbilder der så hadde jeg ikke trengt en tredjepart sw

-

-

syar2003 skrev (10 minutter siden):

Trenger ikke egen programvare for dette.

For merko så er vel ikke et eget program nødvendig i og med at han bare har 2 skjermer. Det er heller ikke problem med 5 skjermer. Men 6 skjermer og oppover så vet jeg ikke hvordan UltraMon håndterer det.

-

-

Så jeg har fått testa ut DisplayFusion 30 day trial en liten stund, og jeg merket med engang at CPU gikk opp til 70% utlization og gjorde OSet laggete/ubrukelig og RAM util til 70% av 32 GB. Dette er når jeg har tatt i bruk 6 skjermer. Er ingen grunn til at det skal ta så mye ressurser når jeg har gjort endringer på noen grunnleggende settings i displayfusion SW'et.

Displayfusion 6 skjermer bakgrunn config fungerer bra til fler enn 5 skjermer, men når det tar så mye ressurser har jeg ingen interesse i å bruke det.

Hadde vært fint hvis noen kunne ha stengt tråden

-

aklla skrev (42 minutter siden):

Diskusjon.no har da ingenting med noe her, utenom at spørsmålet stilles her..

hæ.

sitat fra trådstarter

"Hei Nettverks avdelingen her på diskusjon."Jeg tolker det at det er fra diskusjon nettverksavdelinga.

-

Chris93 skrev (3 minutter siden):

Er dette humor?

Ment som alvorlig ja med en dæsj med humor.

-

Trur diskusjon.no avdeling bør finne seg en ny nettverks person eller hele avdelingen.

Hvis du ikke engang vet forskjellen på en hub og switch så bør du holde deg unna drifting av nettverksavdeling.

Vent, bruker dere Windows Server 2000 og eller?

-

det fulgte ikke rackrails for mine 3 BlueWalker UPSer heller,måtte kjøpe de på multicom.no. Ser at UPSen veier 7.6kg, er ikke det meste, men hadde ikke turt å bare festet UPSen med rack muttere.

-

fulgte det med rackrails?

Du bør også ha UPSene bunn av rackskapet, Tunge ting nederst.

-

1

1

-

-

Emile the rat skrev (10 minutter siden):

Dagens skjermkort er på slutten av sin levetid. Nye skjermkort er forventet i løpet av året, så derfor er dette et veldig dårlig tidpunkt å kjøpe PC.

joa,men så er er de nye RTX korta rumored til ha helt nye 12pin power connectors som krever helt nye PSUer så. Men håper det virkelig bare er FE GPUene isåfall.

-

Du kan jo sjekke ute Glasswire overvåking sw. Det er 30 dager gratis prøve tid..

-

Det er helt patetisk av organisasjoner som lar seg bøye under dette bullshittet med master og slave og whitelist og blacklist. forbanna PC folk som ødelegger alt.

-

1

1

-

-

Comma Chameleon skrev (4 minutter siden):

Den kan fint stå på i mange timer. Alt fra 2-10 timer i løpet av en dag.

Det er jo ganske bra, Hvilken produsent har du a?

-

Comma Chameleon skrev (8 minutter siden):

TV titting og spilling her (mye statiske elementer på spill). Ikke er eneste problem.

Og mye mer avslappende å bare plugge i og bruke tvn normalt framfor alt styret.

Hvor lenge spiller du av gangen a?

samme spørsmål gjelder for tv titting.jeg har lyst på OLED kvalitet, men ikke hvis TVen gir innbrenning ved pause på spill/serier på 2-3t eller film pause.

Er heller ikke interesert i å ta flere forhåndsregler slik som at jeg bekymrer meg for statiske elementer når jeg spiller i flere timer av gangen.

Så på en YT video der ene personen hadde statisk bilde på OLED i 24timer og man ser at det allerede har gitt svak innbrenning.

-

1

1

-

-

ilpostino skrev (1 time siden):

Rart ikke driveren til grafikk-kortet hadde muligheten for dette.

Jeg mener bakgrunnsbilder, hvis det står et eller annet sted inne på NVCP så hadde det vært supert, men jeg har ikke lagt merke til det på NVCP.

-

Så, jeg har 5 aktive skjermer i bruk med forskjellige native resolutions, men en liten periode hadde jeg en QHD 25" som 6e skjerm, den 6e skjermen fikk automatisk samme bakgrunnsbilder som den 5e skjermen. Fins det no 3rd party SW som gir meg mulighet til å velge 1 forskjellig bakgrunnsbilde per skjerm?

-

NULL skrev (3 timer siden):

Relevante her er vel i praksis to ting: Hva en plattform støtter og hva som ellers ligger til grunn i de offisielle DDR4-spesifikasjonene fra JEDEC. I praksis kan man ha en høyere standard fra JEDEC, men hvis ikke plattformen støtter det, vil det uansett være snakk om overklokking.

JEDEC lister DDR4-3200 som det høyeste. Hva som videre er relevant for om man følger den offisielle spesifikasjonene, er verdiene for timing og latency. En plattform og minnemoduler kan være klassifisert for høyere verdier. Intel har vel imidlertid - tradisjonelt sett - sjeldent gått ut over de offisielle JEDEC-spesifikasjonene.

Strengt tatt kan man vel også si at "MHz" ikke er det riktige å bruke her, ettersom man for - eksempelvis - DDR4-3200 har 400 MHz-klokkehastighet, men antallet overføringer per sek er det man vil vise til - da 3200 Megatransfers/sec (flere operasjoner utføres per klokkesyklus).

Jeg regner jo med at det gjelder de offisielle specsa.

Du kan bruke 2133Mhz eller PC4-19000 f.eks. som du sier for å snakke om hastigheten.. Men er mer kjent å si 3200 Mhz enn PC speeds -

TheKims skrev (2 minutter siden):

2933Mhz er stock hastighet. Skal man bruke RAM som kjører høyere frekvenser så er det overklokk.

ehm nei,2133Mhz er stock hastighet for DDR4. Alt over det er beregnet overklokk.

-

Trond HB skrev (14 timer siden):

Det bildet ser jo mye bedre ut, og ikke så tykk, men syns de kunne ha valgt 5000 ah batteri.

Fortsatt idiotisk navn på telefon som er bestemt av Sony.

-

Trond HB skrev (11 timer siden):

Lønner seg bestandig å sjekke fakta før en slenger ut påstander. Den har 802.11ax. Står klart og tydelig i spesifikasjonene på Sony sine sider. At den er så tykk stemmer vel heller ikke. Har akkurat samme tykkelsen som Samsung S20, 7,9 mm.

Når det gjelder navnet så har de begynt å følge praksisen til Sony sin kamera-avdeling.

men første innlegg i denne tråden når jeg elser over trådløse standardarder så står det ikke ax.

Det er fult mulig det ikke stemmer, den bare ser så tykk ut på bildene her.

Det gir ikke mening å navngi telefon fordi kamera avdeling til Sony har standarder for sine kameraer.

-

For et fordelig navn på en telefon Xperia 1 II, hva blir neste da a? 1 III eller xperia 2 II?? for en dårlig valg av reboot av Xperia linja.

og hvorfor ser den telefon ut på bildet så utrolig tykk ut, ser ut som den har plass til Zerolemon 20k batteri jo. Ser jo ut som telefon er tykkere enn Nokia 5110. Er jo andre tynnere modeller som har 5000 Ah batteri kapasitetDet er jo også helt tåpelig at telefon ikke får 802.11ax standarden.

Og hva er det Sony holder på, gjør det mulig at en ps4 kontroller kan kobles opp til en liten skjerm, ser jo ikke engang hvor mobilen er jo. Akkurat som gamere virkelig kommer til å spille ps4 spill på en 6.5" med uhd oppløsning når de fleste kan spille på en 65" TV som har ordentlig HDR og ikke no mobil HDR gimmick.

Det eneste som er bra med den telefon er jo de gir deg mulighet for ekstra SD kort, noe andre rett og slett ikke bryr seg om lengre.

-

Mariabella skrev (4 minutter siden):

Hei, jeg tenker på lisens for livstid. Ingen årlig abonnement. Kun engangsbetaling for hele pakken.

Da må du nok kjøpe Home & Student versjon. Du får word,excel ,powerpoint som standalone for 1399. Ellers fins det sikkert muligheter ebay eller scdkey greysite sidene.

-

Settlers reboot skal jo komme ut i 2020.

AoE 3 DE skal også komme i 2020

AoE 4 er fortsatt usikkert, har ikke sett no data på at det skal bli lansert i 2020. Men er en mulighet for at det blir lansert i år.

Og som andre nevner C&C remaster 5 Juni trur jeg det er.

Programvare i WIndows for støtte til 6 monitorer som har 6 forskjellige bakgrunnsbilder?

i Programvare

Skrevet

Alle Skjermer har sine videostrømmer/output på skjermkortet der ingen deler 1 output på gpu'n. Så ja,brukes flere utganger:)

er MST rettet mott daisy-chaining eller?