-

Innlegg

3 256 -

Ble med

-

Besøkte siden sist

Innholdstype

Profiler

Forum

Hendelser

Blogger

Om forumet

Innlegg skrevet av Emile the rat

-

-

neglesprett skrev (8 minutter siden):

Lite forskjell mellom screeshotta, hva skal man se etter?

Noen mener at DLSS gir dårligere bilde enn native oppløsning.

Derfor utfordret jeg den påstanden med screenshot av native oppløsning vs DLSS, for å se om folk faktisk ser forskjell, om DLSS virkelig er dårligere enn native som enkelte hevder.

Derfor la jeg ut screenshot, så kan folk bedømme selv

-

Ooinaru skrev (Akkurat nå):

Bildene taler for seg selv, utvilsomt imponerende teknologi! Synd det foreløpig ikke er så mange spill som støtter det.

Enig, håper denne teknologien virkelig kommer på banen nå som AMD henger seg på, og nye konsoller støtter RT. Vi trenger konkurranse nå så teknologien går fremover

For denne teknologien er vireklig fremtiden når det kommer til oppskalering

-

shauge2 skrev (10 timer siden):

DLSS 2.0 er fortsatt oppskalering. Native vil alltid være bedre. DLSS 2.0 så ser oppskaleringen finer ut enn i DLS 1.0, men det er fortsatt oppskalering, samme hvor mange ganger innhold fra Nvidia sin reklamebrosjyre blir gjentatt i denne tråden.

Ser du for upvotes for dette, så ønsker å debunke myten om at native er bedre enn DLSS. Utfordrer deg til å faktisk se forskjell mellom native 3440x1440 og DLSS oppskalert fra 1280x540.

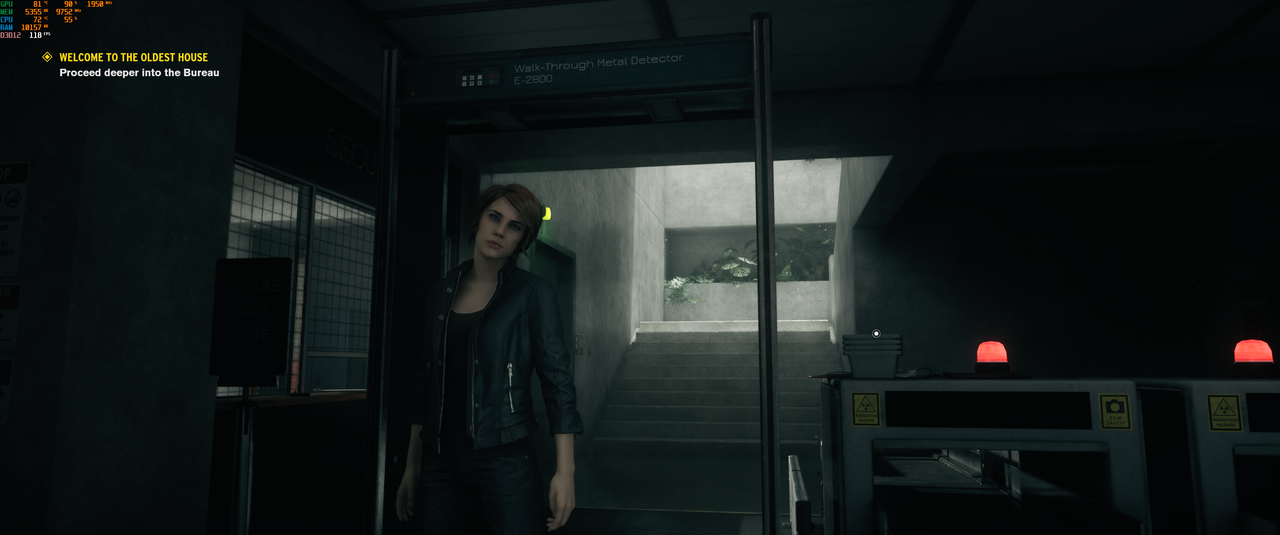

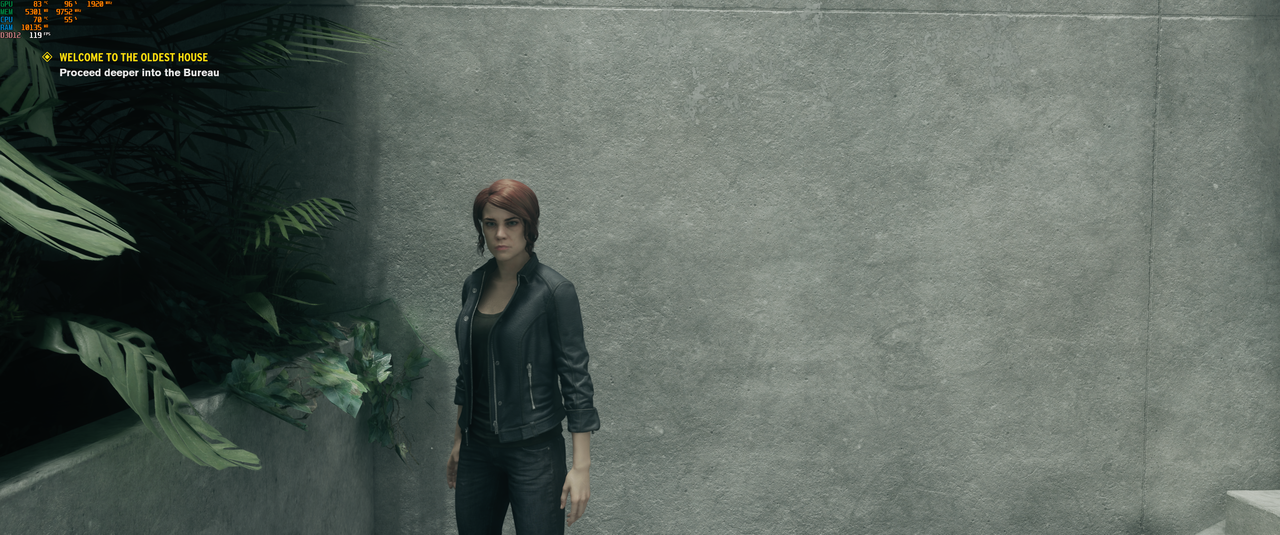

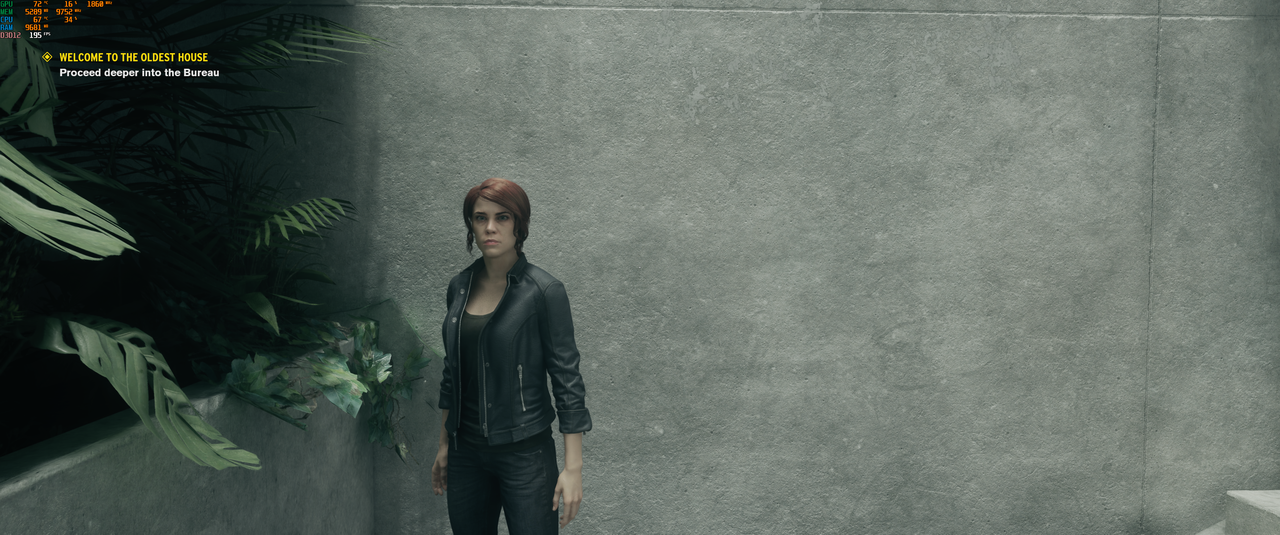

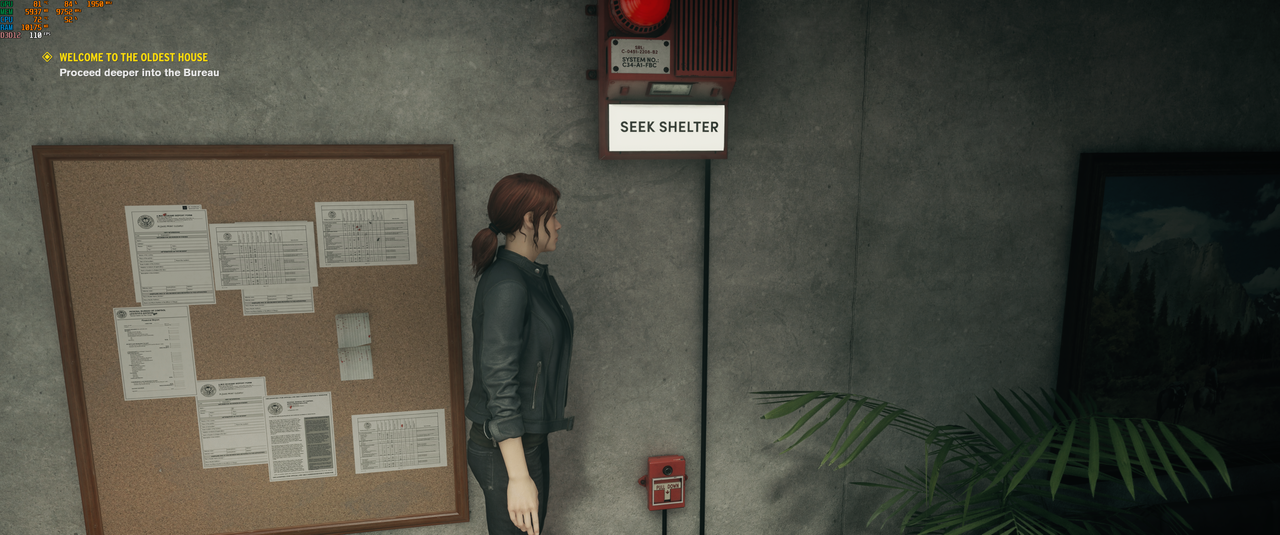

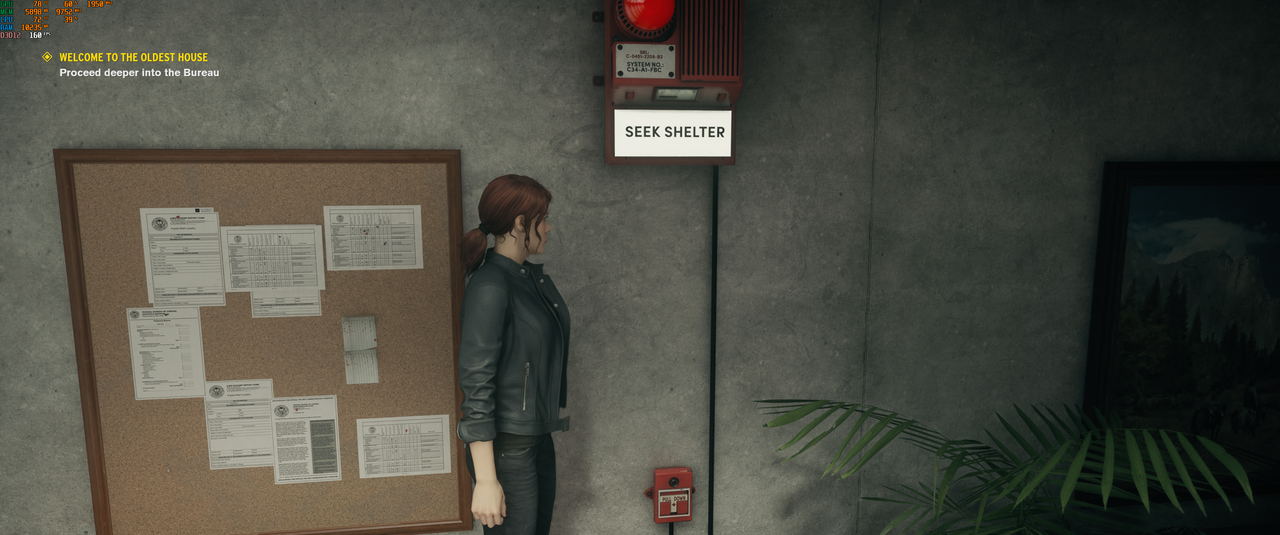

Quality settings som er brukt i Control:

Preset: ultra, SSAO: on, Global Reflections: high, Film Grain og Motion Blur: off. Ray Tracing: ultra.

Til alle som mener at native alltid vil være bedre, ingen av bildene er komprimert. Utfordrer de som mener at DLSS 2.1 er dårligere enn native å peke ut hvor de ser forskjell, jeg kan som sagt ikke se forskjell

Utenom på fps som er vesentlig lavere uten DLSS

Utenom på fps som er vesentlig lavere uten DLSS

Klipp 1: Native 3440x1440

Klipp 1: 1280x540 rendering DLSS 2.1

Klipp 2: Native 3440x1440

Klipp 2: 1280x540 rendering DLSS 2.1

Klipp 3: Native 3440x1440

Klipp 3: 1280x540 rendering DLSS 2.1

Klipp 4: Native 3440x1440

Klipp 4: 1280x540 rendering DLSS 2.1

Fps er noe varierende fordi jeg måtte gå inn og ut av settings for hvert screenshot, men til info får RTX 3090 i snitt rundt 45% høyere ytelse i Control med RTX 3090 når Ray Tracing er på (med mitt oppsett).

Vet denne posten blir litt off-topic, men tenkte den var nyttig som dokumentasjon om noen er usikre på hvordan DLSS påvirker bildekvaliteten. Vet at supersamling, DLSS og RT er teknologier som er relevante for både AMD og Nvidia, og tenker at dette derfor kan være informativt for å debunke noen myter som er på nettet rundt denne teknologien

PS: Dette er ikke innhold fra Nvidia sin reklamebrosjyere, men brukererfaring tatt med mitt eget oppsett. Sjekk profil for specs.

-

5

5

-

-

PaladinNO skrev (2 timer siden):

Det kommer dårlig frem på bildet grunnet vinkelen, men jeg har (heldigvis) god klaring i bredden (fra PCIe-sporet mot glassdøren), for 3080 Aorus er 1 cm. større denne veien også...

Ingen fare med harddiskene - har 11 spor å velge mellom til de 4 diskene.

Men det kan se ut som ihvertfall PCIe-strømkabelen lengst til høyre kan måtte komme litt i knekk mot harddiskrammen. Håper det ikke blir for ille.

F**n for et monsterkort dette er!

EDIT:

Damn...det fancy displayet kan jo bli fullstendig gjemt bak HDD-buret. Jaja, jeg får tegne et smilefjes på en post-it lapp og klistre på metallplaten.

Hurra for kreative løsninger

Her er hva jeg bruker det fancy displayet til:

Noen bruker skjermkort til folding mens jeg bruker det til ostespising

-

4

4

-

-

VegardBS skrev (Akkurat nå):

Tar det som at MSI skjermen ikke er verdt kjøpet da 🙂

MSI skjermen er god i forhold til prisen, men det er som regel alltid noen baksider.

- Høy refresh rate på slike skjermer (denne er VA uten varialbel overdrive) vil nok gi smearing på høy refresh rate.

- Du mister som sagt g-sync, men dette er kun viktig om man har nvidia GPU.

- Noen reviews har klaget på dårlig brightness uniformity, så det vil nok være noe backlight bleed.

På disse punktene tror jeg nok Predator skjermen er en bedre gaming skjerm, den er også IPS.

men alt er relativt, MSI skjermen er ikke dårlig, men når man først skal legge ut så mye er ikke veien opp til X34P så lang

-

VegardBS skrev (12 minutter siden):

Verdt kjøpet?

Skal du først kjøpe ultrawide på black friday er dette en bedre deal

-

Cappo skrev (38 minutter siden):

Bare pirke litt og si at det uthevede ordet her, "derfor", ikke passer inn. Du kan fint være merkelojal uten å være fanboy.

Jeg f.eks er det. Kjøper produktet vel viten om at det er dårligere.

Uansett skjønner jeg ikke at du gidder bry deg. Var ganske opplagt fra start at kortene ikke ville ta igjen Nvidia. De ville være konkurransedyktige, ja. Men uforbeholdent slå Nvidia? Ikke tale om.

Det tok 3 generasjoner med Zen før de slo Intel. Og det vil ta minst 3 generasjoner med RDNA for å slå Nvidia.

Bryr meg fordi fakta og tall er viktig.

Jeg kunne moderert meg til at man kan være merkebevisst uten å være fanboy. Går mer på at jeg er imot brukere som benekter faktiske tall og benchmark, og kommer med alternative fakta fordi de er merkebevisst, er de brukerene jeg går til livs på.

Hvorfor bryr jeg meg? Fordi jeg er imot at folk sprer feilinformasjon og alternative fakta. Rett skal være rett, selv hvor dødelig fornærmet man måtte bli

Diskusjon er gøy, men en polarisert diskusjon hvor «politisk korrekthet» er viktigere enn fakta misliker jeg.

Men i likhet med sikkert deg også er jeg glad for at AMD endelig konkurrerer i topsjiktet igjen

Det kan (ren ønsketenking fra min side) få frem større generasjonsløft og rimeligere priser ved neste generasjon, men det får tiden vise. Nvidia har hatt en stygg tendens de to siste generasjonene til å vise ta at de kan ta akkurat det de vil for sine produkter.

Det kan (ren ønsketenking fra min side) få frem større generasjonsløft og rimeligere priser ved neste generasjon, men det får tiden vise. Nvidia har hatt en stygg tendens de to siste generasjonene til å vise ta at de kan ta akkurat det de vil for sine produkter.

-

Orwandel skrev (17 timer siden):

Klarer du å lage en eneste post uten å bruke ordet fanboy? Ad hominems bidrar ikke til diskusjonen.

Søkte opp definisjonen på ad hominems nå, som sier følgende:

«attacks the characteristics or authority of the writer without adressing the substance of the argument».

Hvis jeg hadde brukt ad hominems ville jeg ikke begrunnet hvorfor jeg kaller noen fanboys, men det har jeg. Veldig mange ganger også, kan gjøre det igjen,

Jeg har vært veldig tydelig på at de jeg kaller fanboys er personer på forumet her som nekter å anerkjenne alle benchmarks, tall og tester hvor 6800 XT kommer dårligere ut. Hver gang jeg eller andre har jeg lagt ut kilder hvorfor Big Navi kommer dårligere ut, benektes dette og avfeies som «fake news».

Det er en tydelig holdning hos flere brukere her at alle kilder hvor AMD kommer dårligere ut er fake, og det er på det grunnlaget jeg mener at noen er fanboys.

Jeg mener at enhver bruker som ikke annerkjenner offisielle benchmarks og tall (dersom de ikke går i deres favør), og heller baserer sine utsagn på enkelttilfeller, og nekter for alle andre resultater er en fanboy, om det så gjelder AMD, Intel eller Nvidia.

Jeg har ikke brukt ad homines, men jeg har kun outet brukere for å være særdeles partiske, og outet brukere som nekter å annerkjenne tester eller kilder som sier dem imot.

Men jeg ser at det derimot er veldig populært og henge meg ut, og at alle AMD tilgengerene er raske med å like innleggene så fort det er en fornærmelse, uthenging, latterliggjøring eller personangrep mot meg, fordi det tydeligvis ikke er greit at jeg legger fakta på bordet hvor Ampere kommer bedre ut.

Innlegget ditt her, hvor du beskylder meg for ad hominems, og høster likes fra likesinnede og partiske brukere, beviser hele poenget mitt.

Jeg hadde ikke kalt noen fanboys om de baserte sine meninger på kilder (og da alle kilder, ikke kilder hvor man luker ut alt som ikke passer sitt syn eller ønske). Kaller ingen fanboys bare man kan akseptere eller annerkjente kilder selv om man på personlig grunnlag ikke liker utfallet.

Men brukere som er merkelojale og derfor nekter å godta eller annerkjenne tester hvor det merket de er lojal til gjør det dårligere, er per definisjon en fanboy, uavhengig av hvor lite du ønsker å høre det ordet. Jeg må få bruke et negativt ladd ord, når det faktisk passer.

Minner også om yttringsfrihet, så jeg har min fulle rett å bruke ordet, dersom jeg mener noen er strekt merkelojale, subjektive og partiske i sine ytringer.

-

Nizzen skrev (15 minutter siden):

Guru3d tester overklokken over flere timer i spill for å sjekke om det faktisk ER stabilt. "Hilbert" kommenterte dette selv i en av testene, i kommentarfeltet.

I Heaven får man skyhøy frekvens i forhold til skikkelig krevende spill.

Derfor er nok guru3d sine resultater lavere.

Word, opplevd det samme selv.

Til Benchmarks kjører jeg 2100mhz core, 4000mhz@cl16 på minne og 5.3 på alle CPU kjerner.

Men skal jeg game må jeg ned på 2050mhz core, 4000mhz@cl17 og 5.2 på alle kjerner for at det skal være stabilt i spill over flere timer.

Så benchmarks er en ting, mens relativ ytelse i spill er noe annet ja

-

Theo343 skrev (13 minutter siden):

Spør fordi jeg ikke husker. Kan ikke DLSS også gi en type "billedbehandling fra på TV" effekt? Altså at bildekvaliteten blir litt polert?

Nei, ikke såvidt jeg har opplevd etter DLSS 2.0 kom.

-

1

1

-

-

shauge2 skrev (18 minutter siden):

DLSS 2.0 er fortsatt oppskalering. Native vil alltid være bedre. DLSS 2.0 så ser oppskaleringen finer ut enn i DLS 1.0, men det er fortsatt oppskalering, samme hvor mange ganger innhold fra Nvidia sin reklamebrosjyre blir gjentatt i denne tråden.

Tull, har testet DLSS 2.1 i Control, og selv i font på dokumenter (i spillet) ser jeg ikke forskjell på native 1440p og oppskalert DLSS.

Kan ta screenshot når jeg kommer hjem, så får vi se om du ser for forskjell

-

Cowboystrekk skrev (1 time siden):

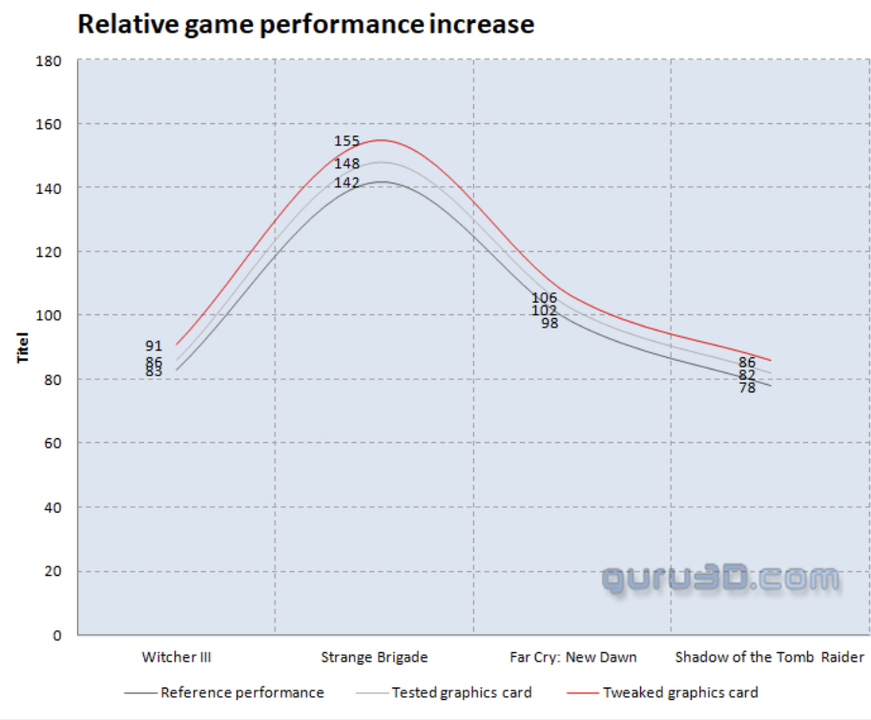

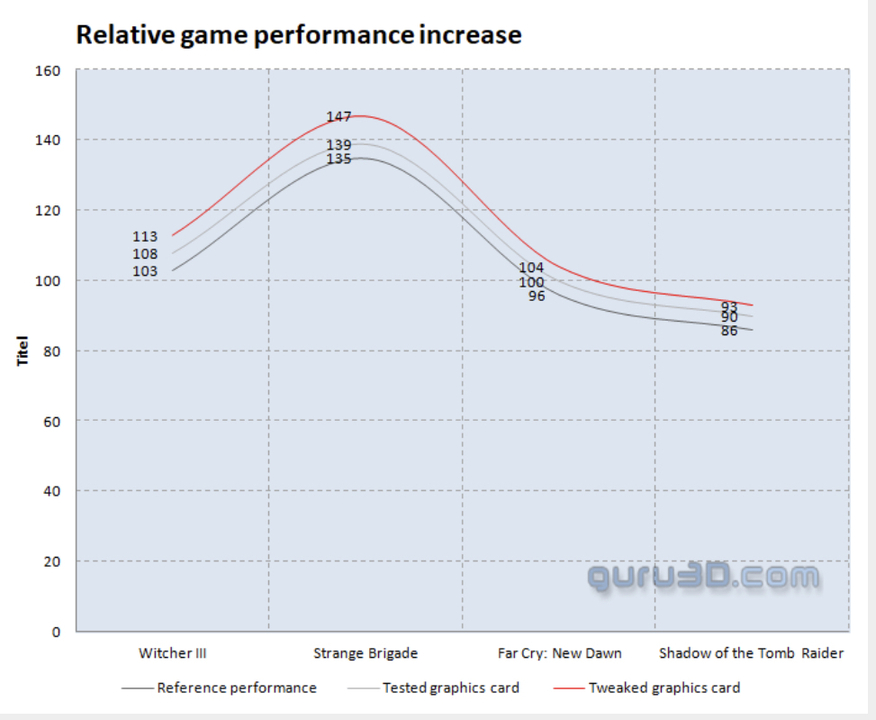

https://www.guru3d.com/articles_pages/asus_radeon_rx_6800_xt_strix_oc_liquid_cooled_review,32.html de fikk tydeligvis et dårligere binna eksemplar enn TPU da de lå 100MHz under med OC, men fikk 5% i spill med 200MHz OC så i TPU sitt tilfelle burde det gitt ca 7-8% i de aktuelle spillene.

Mulig heaven er en best case og gir høyere gevinst enn i de fleste spill, men en vesentlig forskjell på 3090 og 6800XT er at det ser ut til å være mer å hente på kjerneOC med 6800XT, mens 3090 henter mer på minneOC. Noen spill får mer utbytte av kjerne, andre av minne.

Den grafen ser helt lik ut for 3080.

Her er Asus 6800 XT STRIX OC på 2700 Mhz:

Og her er MSI 3080 Suprime X på 2100 Mhz:

Sammenlignet med referansekort, så er det faktisk like mye å hente på overklokk i spill med både Big Navi og Ampere. At det kun er 5% å hente som Noreng hevder stemmer ikke, la oss se på de faktiske tallene fra Guru3D.

Witcher 3:

6800 XT OC 9.6% over referanse

3080 OC 9.7% over referanse

Strange Brigade

6800 XT OC 9.1% over referanse

3089 OC 8.8% over referanse

Far Cry New Dawn

6800 XT OC 8.1% over referanse

3080 OC 8.3% over referanse

Shadow of the Tomb Raider

6800 XT OC 10.2% over referanse

3080 OC 8.1% over referanse

Zlatzman skrev (1 time siden):Sweclockers overklokket sitt Radeon RX 6800 XT til 2550 MHz, og med liten overklokk på minnet. Det ga en økning fra 8301 til 8727 graphics score i Time Spy, tilsvarende 5%. Omtrent samme økning så de i Battlefield V, Control og Metro Exodus. Jeg fant ikke i farten hvilken frekvens kortet kjørte på under stock testene deres, så har ikke sammenlignet med dem.

https://www.sweclockers.com/test/30790-amd-radeon-rx-6800-och-rx-6800-xt/12

Les kommentaren over hvis du ikke tror meg.

Det er så og si like mye å hente på overklokking hos både Big Navi og Ampere.

Myten om at den høye klokke frekvensen er en fordel for Big Navi kan vi legge dø, når 3080 oppnår likt ytelseshopp med overklokk i spill.

-

TemporalFracture skrev (5 minutter siden):

Det virker å være en påstand fra mange hold sist jeg sjekket. Første versjon av DLSS var jo ikke noe spesielt, men seneste versjon er jo utvilsomt verdt det. Men hvor mange spill er det egentlig som støtter det?

I og med at RT har blitt et stort salgsargument for next gen konsoll, vil vi vel se stadig mer av det i kommende spill.

Å ikke ta høyde for at RT og DLSS blir standard i de fleste kommende aaa spill tror jeg er dumt.

-

Cowboystrekk skrev (14 minutter siden):

Ut av eska er max boost 2486, med manuell OC 2743. Ytelsa økte med 10.9% i heaven og trolig ca det i spill og.

Neppe.

I Firestrike øker ytelsen betraktelig med høy core clock.

Et overklokket 6800 XT kan score høyere enn 3090 i FireStrike, men den ytelsen kan ikke overføres til spill, for jeg har ikke sett noen benchmarks som konkluderer med at 6800 XT er i nærheten av 3090, selv når overklokket.

Syntetisk benchmarkytelse kan ikke overføres til ren gamingytelse uten å skalere. Så 10% bedre ytelse i Heaven vil ikke tilsvare det samme i spill.

Jeg kan få vesentlig høyere score i Heaven med overklokk på mitt 3090, men i spill ser jeg ikke samme gevinsten.

Har du derimot en kilde på påstanden din?

-

Ooinaru skrev (Akkurat nå):

Er det ikke en egen tråd for AMD vs Nvidia? Dette er vel en tråd utelukkende for RDNA 2?

Når man diskuterer ytelse, så er det vel nærliggende at man må kunne sammenligne det opp mot konkurrenten.

-

henrikr skrev (13 timer siden):

Du som har bra peiling

Hvordan er denne da?

https://www.dustinhome.no/product/5011192294/c34h890wgu

Edit; å ja ser ut som den kom for 3 år sidenIkke vært borti den skjermen, men fra det jeg kan se er største forskjellen på den og Samsung C34F791 at H890 ikke har QLED, mens F791 er QLED.

Spørs hva skjermen skal brukes til. F791 har nok mer «ekte» farger og er nærmere IPS pga quantum dot telnologien, mens H890 som er VA panel vil nok ha noe mer utvasket farger enn storebroren.

-

Nizzen skrev (11 timer siden):

True story!

Hvis de tør å teste da... Det er noe annet

Techpowerup har turt, og der scorer 3080 bedre enn 6800XT, selv i 1080p.

Men benchmarkene til techpowerup er tydeligvis ikke gyldige i AMD leiren fordi de bruker 5000mhz på CPU core og 4000mhz på minne 😛

-

Orwandel skrev (13 timer siden):

Klarer du å lage en eneste post uten å bruke ordet fanboy? Ad hominems bidrar ikke til diskusjonen.

Hvor har jeg brukt ordet fanboy i posten du linket?

De eneste jeg har kalt fanboy er brukere som har blånektet på tall fra faktiske benchmarks. Og det er jo per definisjon en fanboy, om du liker det eller ikke.

leifeinar skrev (13 timer siden):Vi er nok få dager unna 3 ghz, ihvertfal 6900xt med beste binning

Kilde?

N o r e n g skrev (11 timer siden):Det må du nesten komme med kilde på. Techpowerup sin test tilsier at kortet kjører rett over 2400 MHz

https://www.techpowerup.com/review/asus-radeon-rx-6800-xt-strix-oc-lc-liquid-cooled/30.html

2743 Mhz

https://www.techpowerup.com/review/asus-radeon-rx-6800-xt-strix-oc-lc-liquid-cooled/38.html

Du må lese hele testen. Det du linket til var stock core.

-

vara skrev (11 minutter siden):

Jeg hadde rett i paperlaunch for AMD men mistenker at AMD har kunstig begrenset boosts på sine kort. Hvis dette blir endret på (lik previous generations) så kan det hende RX 6800XT > RTX 3080 gitt samme pris for alt unntatt raytracing. Hvis performance delta på ordinær rendering blir for stort så er ikke alle ekstra features fra Nvidia verd det for den ordinære gamer.

Asus 6800 XT STRIX LC har boost på nesten 2.8 Ghz ut av esken, og du spekulerer i at AMD har satt på begrenset boost på sine kort.

Jaha.

-

Pc Lynet skrev (Akkurat nå):

Han har gode tilbakemelidinger på finn. Man bør alltid gjøre litt research før man handler med folk på finn.

Blir bare automatisk skeptisk når jeg ser annonser uten bilde. Det går fortere å ta et bilde på telefonen i finn.no appen enn å finne et bilde man har stjelt på nett. Så når folk istede tar seg bryet med å stjele bilder til annonsene sine tenker jeg atomatisk skip, hva enn tilbakemeldinger brukeren måtte ha.

Men det er meg da

Forsåvidt enig i at det er bra med tilbakemeldingsfunksjonen som er på finn

Forsåvidt enig i at det er bra med tilbakemeldingsfunksjonen som er på finn

-

1

1

-

-

PaladinNO skrev (1 time siden):

Teknisk sett bare 300 Kr. 12.000 hos Komplett - 10% rabattkode = 10.800 Kr.

Men dette var også grunnen til at jeg ikke hoppet på Komplett og brukte rabattkoden for å få kortet før - jeg hadde allerede ventet så lenge at å bruke koden og forsatt bruke mer penger, men få kortet før, ikke gjorde det verdt det.

Da har man jo den rabattkoden til overs

Pc Lynet skrev (17 minutter siden):

Pc Lynet skrev (17 minutter siden):Hvis noen sitter med ett 3090 ventekort kan du bytte deg ned til 3080 her. Legg merke til prisen 12 345kr

Har han egentlig noe kort? Er ingen bilder der.

A.Jobim skrev (4 minutter siden):Har noen her handlet fra Proshop og sett noen framgang? Enten kort som har blitt sendt eller oppdatert ordre. Kan fint vente jeg altså, men det virker ganske fattig det de får inn i følge denne trackeren deres, som jeg regner med er for alle Proshop avdelingene i Norden.

Proshop funker bra det, men er nok lang ventetid hos de fleste butikker

-

RRhoads skrev (1 minutt siden):

Det er et godt poeng. Jeg spiller ganske mye forskjellig. Det jeg spiller minst av er vel skytespill.

Her går det altfor mye i minecraft, da er det jo ekstra kos med stor skjerm

-

1

1

-

-

RRhoads skrev (5 minutter siden):

Med full overdrive blir etterslepet mindre, men skjermen overkompenserer. Kan sikkert være bedre i noen titler. Men greit å vite hvis FM er en av titlene man spiller mest. Da ville jeg unngått å kjøpe VA.FM21 har veldig enkel grafikk, og kontrasten er relativ stor mellom spillere og bane, spesielt mørke drakter.

Har egentlig ikke hatt noen store problemer med etterslep før dette spillet her, bortsett fra ved nettleser/scrolling.

Jepp, men nå tror jeg ikke folk flest bruker over 20K på skjerm dersom hovedspillet er FM21

Men joda, sjekt å vite, selv om FM nok ikke helt innenfor mine type spill

-

RRhoads skrev (4 minutter siden):

Er ikke så merkbart på IPS som på VA, i hvert fall. Merker ekstrem stor forskjell på X35 og AW3420D i FM21. Skal sies at man ser etterslep veldig godt i det spillet.

Vil nok tro at det har mye med type spill ja. Ikke lagt noe spesielt merke til etterslep på min skjerm, kjører full overdrive

AMD RDNA2 (Radeon RX 6xxx)

i Skjermkort

Skrevet

Kjempe kult at noen tar utfordringen Må innrømme at du har godt syn for detaljer

Må innrømme at du har godt syn for detaljer  Arkene på kortavlen var det eneste jeg la merke til ved første øyekast

Arkene på kortavlen var det eneste jeg la merke til ved første øyekast

Men så er spørsmålet, er dette merkbart når man spiller. Ville du klart å skille native og DLSS dersom du spilte spillet uten å vite om det var brukt native eller DLSS. Selv hadde jeg ikke hatt sjans, så all cred til de som klarer det