fa2001

-

Innlegg

797 -

Ble med

-

Besøkte siden sist

Innholdstype

Profiler

Forum

Hendelser

Blogger

Om forumet

Innlegg skrevet av fa2001

-

-

Har BIOS 0441 i følge Armoury Crate, men sitter med Remote Desktop og får ikke sjekket i BIOS. Jeg har en stund ignorert melding om ny ME firmware, som jeg bare får i Linux - får se på det.

Det er litt flaut, men jeg har funnet mulig grunnen: kjøling. Jeg satt en vifte rett inn mot minnet, og det kjørte stabilt i 2 timer i går kveld. Nå har jeg fjernet den viften igjen og snudd viftene i PCen, og det er foreløpig stabilt i flere timer. Før hadde jeg at radiatoren dumper varmen fra CPU inn i PCen, av praktiske årsaker og oppvarming av beina, men nå suges varmen rett ut.

Når PCen var ny sjekket jeg med TestMem5, og måtte gjøre noen innstillinger for å få det stabilt - men det ble stabilt til slutt. Kanskje Prime klarer å lage mer varme, og at det derfor kom feil på minne. Men Prime er rart.

Neste blir da å starte en uavhengig prosess som bruker 100% GPU og kjøre samtidig med Prime, for å produsere mest mulig varme i kabinettet. Og memtest86 og TestMem5 bør vel også kjøres igjen for å være sikker.

-

Tusen takk for svar! Jeg har samme HK! Dette kan være jeg har samme problemet

Jeg mener at det ble bedre etter at jeg tok ut og satt inn minnebrikkene igjen - fra ca 20 min til litt over en time før det kom feil. Har litt å jobbe med nå, skal kjøre flere Prime95 tester og kanskje memtest86, dobbeltsjekke at de to står helt godt i.

Jeg mener at det ble bedre etter at jeg tok ut og satt inn minnebrikkene igjen - fra ca 20 min til litt over en time før det kom feil. Har litt å jobbe med nå, skal kjøre flere Prime95 tester og kanskje memtest86, dobbeltsjekke at de to står helt godt i.

CPU: Intel 13900KF

Minne: G.Skill Trident Z5 DDR5-6000 BK C32 DC - 64GB (https://www.proshop.no/RAM/GSkill-Trident-Z5-DDR5-6000-BK-C32-DC-64GB/3102557)

Hovedkort: ASUS PRIME Z790-P WIFI -

PCen har vært stabil før, men var nylig ustabil i et spill og jeg begynte å teste med Prime95. Jeg har et sett med 2 stk minnebrikker med frekvens 6000 MHz. Jeg har brukt innstilling XMP I og ingen annen overklokking. Det blir feil i Prime95 alltid før 2 timer har gått.

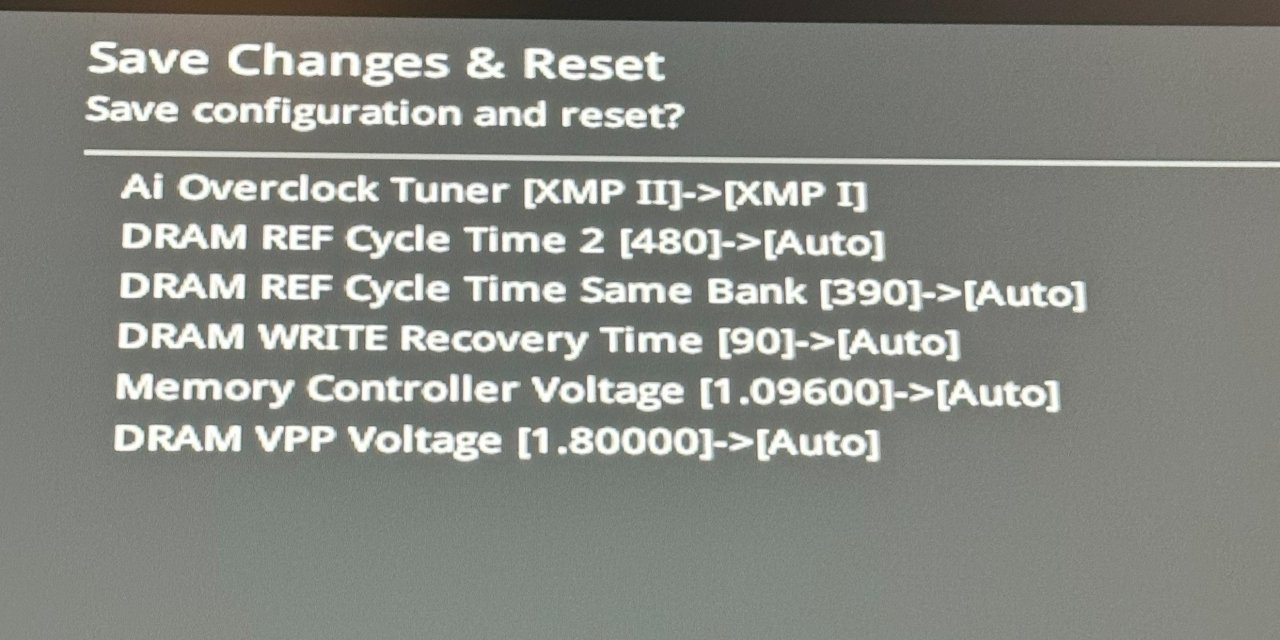

ASUS-hovedkortet har to XMP-innstillinger, XMP I og XMP II. Ved XMP I bruker den ASUS-optimaliserte verdier, ved XMP II bruker den flere parametere direkte fra minnets XMP-profil (se bilde).

Ingenting fungerer ved XMP II. Den vil ikke boote med en og en minnebrikke, ikke begge to. Den kan boote i ASUS safe mode 4000MHz.

Ved XMP I får jeg stabilt (> 2 timer Prime95) med en og en minnebrikke, men får feil med begge på en gang.

--

Jeg har to spørsmål (jeg er meget frustrert over dette og setter stor pris på svar:):

1. Kan jeg egentlig forvente å få helt stabil PC, eller i hvert fall få regnefeil over mange døgn, når jeg bruker XMP? Jeg vurderer reklamasjon, men det er jo vanskelig å si om det er minne / CPU eller hovedkort som er problemet.

2. Finnes det noen "overklokkings"-innstillinger som kan fikse stabiliteten? Hva er evt mest relevant å begynne å teste, spenninger?

-

For å avslutte denne: Jeg ventet månedsvis men fikk aldri IPv6 på Asus igjen heller. Etter hver fikk jeg IPv4-adresse. Grunnen er at jeg har byttet modem sinden dette fungerte på Asus. Jeg spurte Telia på chat og de sa at mitt nåværende modem ikke støtter IPv6. Ok.

-

Jeg har hatt god erfaring med Apple(!) sine USB-C overganger, det gir relativt god lyd i min mening. Det fungerer på div Android-telefoner og et gammelt Samsung-nettbrett som jeg fortsatt bruker. Den har lavt volum på utgangen, men det funker veldig bra på ørepropper, som gjerne er lettdrevne. Den er kompatibel med Apple type volumkontroll & pauseknapp på 3,5mm-siden, men på USB-C siden virker det fint med Android-tlf. Jeg har satt på varmekrympe-slange fra Clas Ohlson for å gjøre overgangen litt mer robust.

-

Takk, det hjelper veldig å vite at det er 56! Har prøvd alle mulighetene og det gikk ikke med en gang, skal si fra hvis det løser seg.

-

Det skal sies at jeg prøvde med Asus igjen nå uten hell. Tror jeg er tom for IPv4-adresser i hvert fall. Jeg har brukt opp 2 stk IPv4-adresser på VMer og en på pfSense, og Telia begrenser det til 3 (public) adresser. Slår av en VM og venter 2 dager, så tester jeg med Asus igjen om den får IPv4 og IPv6 adresse.

-

Før brukte jeg Telia-boks i bromodus og Asus-ruter, og IPv6 fungerte fint. Fikk unike public IPv6-adresser på alle maskiner koblet til lokalnettet.

Jeg har byttet ut Asus pga noen problemer, og vil bruke pfSense. Altså pfSense som ruter og Telia-boks som kabelmodem.

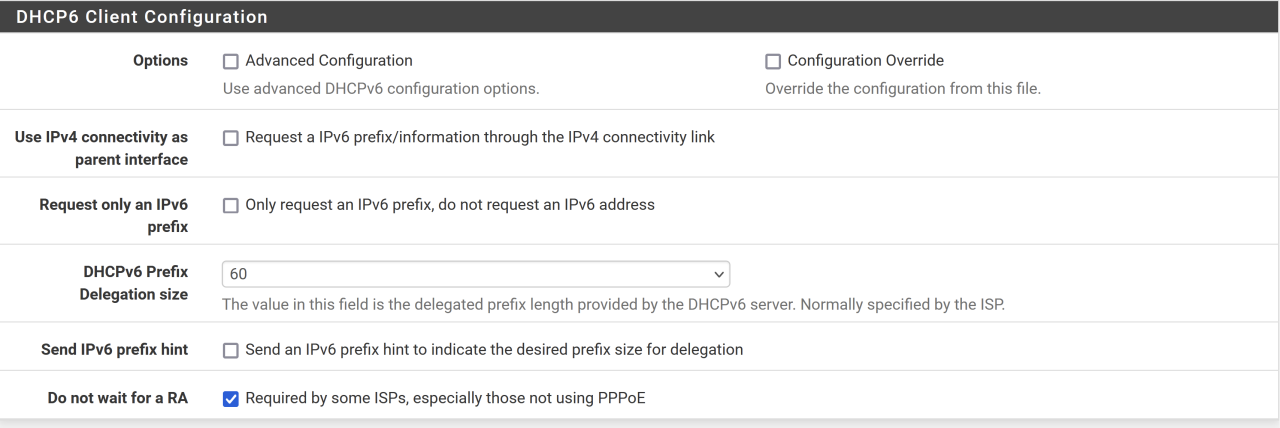

Med pfSense så får jeg ikke IPv6-prefix via DHCP6. Er det noen som vet korrekte innstillinger for Telia, og/eller får brukt DHCP6-PD på noe som ikke er Telia-boksen?

Jeg har prøvd forskjellige Prefix size og andre valg i pfSense. Får aldri noe svar fra Telias server. Nå har jeg bruktbare pfSense i en måned (med bare IPv4) i håp om at en eventuell DHCP-lease tilhørende Asus skulle gå ut, men det fungerer altså ikke.

-

Voro skrev (På 12.12.2022 den 12.29):

Noen her som har kjennskap til tekproffen.no? Ser de har mange RTX 4090 kort på lager til mye lavere pris enn Komplett etc.

Jeg bestilte fra Tekproffen på tirsdag 8.12., fikk en sendingsbekreftelse 12.12. uten sporingsnummer. Sendte en mail i dag (15.) for å spørre når den kommer. Må si jeg begynner å bekymre meg ørlite grann.

-

Ser at det står 253W en del steder ("Intel-recommended specs of 253W maximum turbo power" https://www.club386.com/intel-core-i9-13900k-review/ ). Så vidt jeg skjønner så kan de nyere Intel-cpuene kjøre på max turbofrekvens så lenge de vil, helt til de blir for varme.

-

Det var lavere enn forventet basert på div tester jeg har sett på Youtube. Feks Hardware Unboxed har ikke overklokket, men de så veldig høy strømbruk (men de oppgir primært total system load, ikke bare CPU). Man kan se at Total Package Power ligger mellom 200 og 250 W. Eksempelet i videoen er ikke vanlig gaming bruk, men jeg har også tenkt å bruke den til dataanalyse, programvareutvikling og kanskje litt 3D arbeid. Ellers ville jeg sett på 13600K i stedet.

-

Jeg er interessert i Intel 13900K og skjønner at den krever kraftig kjøling for å yte optimalt. Jeg kommer ikke til å overklokke.

Anta at kjøling og PSU er på plass, men si at jeg kjøpte et "billig" Z790 hovedkort. Kan det hende at CPUen må bremse ned fordi hovedkortet ikke klarer å gjøre om nok 12V strøm til CPUens spenning?

Det er dårlig med specs for Z790-kortene i nettbutikkene, men selv på eldre hovedkort står det ikke noe om maksimal Watt for CPU. Så jeg lurte på om det var standard, om det f.eks. kreves at alle LGA1700 HK støtter 300 eller 350W?

-

Jeg har ikke noe svar, men vil nevne et alternativ hvis du absolutt ikke finner noen plugger: dongle. Jeg ble positivt overrasket over prisen og lydkvaliteten på Apple sin: https://prisguiden.no/produkt/apple-usb-c-til-3-5mm-352560 . Funker med Android, men kan gi veldig lavt volum på noen telefoner. Kabelen er tynn og virker skjør. Jeg brukte først brun teip for å forsterke den, men har satt på en krympeslange, så nå er den gul og rød

(Når det er sagt, har jeg akkurat ødelagt en dyr ørepropp, og kom hit fordi jeg lurer på om jeg skal gå for trådløst selv eller ikke. Mange som anbefaler det / liker det veldig godt)

-

Rart at man funderer og spekulerer på gammelt lovverk, men ikke et eneste parti går til valg på å endre loven og forby disse tingene.

-

Fin idé, skal prøves:)Lad med en treg lader. F.eks fra usb porten på pcen din som bare levere 500mA.

-

Har lurt på dette, for det å ligge på 100% er en avveining mellom to dårlige ting: man reduserer antall ladesykler, men man må ligge på et ekstremt nivå (100%).

Jeg kan sitte på kontoret i 8 timer,og lurer på om det er bedre å være plugget inn .. og batteriet er i praksis frakoblet,mobilen trekker det den bruker av strøm tett fra laderen. Eller bruke opp noen % og deretter måtte lade disse igjen, men kan ligge på et bedre nivå . Kanskje det også påvirkes av om jeg bruker apper,feks. musikk.

Det samme gjelder over natten,men der er forbruket minimalt,og det er verre hvis det begynner å brenne, noe som tåler for å plugge ut.

Det finnes en "charge limit" app, om kan dtoppe lading på f.eks 80 %, men den krever root og vet ikke hvor godt det fungerer.

-

Bra artikkel, liker at dere viser bare FPS/kr, .. så kan man se på ting som effektbruk og FreeSync i anbefalingene, men da har man noe å starte fra.

Så dere liker ikke Blower altså? Forrige gang jeg skulle ha skjermkort så så jeg etter akkurat blower -- det er varmt i PCen uansett, greit å ha noe som suger ut varmen i stedet for å legge til mer varme. Et motargument er at det er bedre å blåse inn luft i PCen enn å suge ut (de burde vel kalles sucker egentlig). Det er bedre å ha noen få vifter med filter foran og overtrykk inni, sånn at man ikke suger inn støv fra alle kanter.

Men nok om det, funnene deres gjelder vel også relativt det samme for "sucker" kort hvis man vil ha

-

Er disse komponentene produsert som forbruker-komponenter eller Enterprise-komponenter?

Enterprise-komponenter er produsert/konfigurert for å gå 24/7. Jeg vet ikke, men tror ikke forbruker-komponenter er produsert med tanke på samme bruksmønster, og vil være særdeles skeptisk til å kjøpe disse brukt.

Jeg er alltid positiv til skepsis, og nVidia/AMD gjør nok ikke noen ekstra innsats for å gjøre at komponentene kan kjøres i ukesvis på full last. Men de må da lages for å takle gaming-maraton på 16 timer minimum. Så er spørsmålet om det er noen forskjell på hvordan de må lages for å takle 16 timer vs 720 timer med oppetid. Termisk design må tåle kontinuerlig kjøring, that's it. Kulelager i vifta kan vel gå, men mange kjører PCen 24/7 på idle, og det må produsentene ta høyde for uansett. Så det som gjenstår er ren slitasje på elektronikken, dvs å flytte på ioner inne i kretsene. Det skjer, men det er en treg prosess. Er det noen her som har hatt en CPU eller skjermkort som har gitt seg pga "slitasje"? Ikke dårlige komponenter, som kondensatorer f.eks., som skjer uansett, altså.

(edit) Bare kom til å tenke på, hvis jeg måtte ta sjansen på et skjermkort uten noen garanti, ville jeg heller tatt et som hadde kjørt i en mining rigg over vinteren -- en "episk" burn-in test -- enn et helt nytt et.

-

1

1

-

-

- Her er det snakk om avlange pixels..., eller rektangulære for å si det på en annen måte.

For å være pirkete... De aller fleste pixler (unntatt Pentile) er rektangulære, et kvadrat er også et rektangel. Liker "avlange".

-

1

1

-

-

"Mediet kunne ikke avspilles"?

-

På papiret har den en bedre penn også, men det har vi ikke testet så veldig hardt.

Samme hvor hardt du skriver, denne pennen skal brukes på skjermen, ikke papir

-

Nei det var synd. Jeg holdt på å gi opp på Bitcoin, men så at Steam og mange andre tar det, og tenkte at det var litt kult allikevel. På mange måter er det lettere å kjøpe et spill for bitcoin enn å dra frem kortet og faktisk føle det på brukskontoen. Men må innrømme at det er lett å glemme, og jeg kjøper ikke mange spill uansett. Kommer Microsoft, Expedia og andre til å følge nå...? Da er det vel bare å selge det man har av BTC.

-

4 GB RAM, er dette en gammel sak fra 2014 eller?

-

1

1

-

-

Utgir sikkert en del varme denne skjermen..Okey matten min var helt feil, 8 millioner pixler, hvis vi sier at hver pære tar ca 0.004W blir det ca. 32KW.

Noe som ikke er så skremmende mye, tipper at lydanlegget krever like mye

Jeg kom også opp med 0,004W per pixel (http://ledtronics.com.my/wp-content/uploads/2016/10/P2.5-Indoor-SMD-LED-Video-Display.pdf ). Men fordelen med LED er at de ikke bruker strøm når de ikke er på. Når de viser filmer vil de trekke betydelig mindre enn hvis de viser en hvit skjerm. Projektorer må derimot ha pæra på hele tiden, selv om de viser en sort skjerm..

Små feil ved XMP-innstillinger - forventet eller feilvare?

i Overklokking og entusiastbruk

Skrevet · Endret av fa2001

Det er fortsatt ingen feil, dette er helt fantastisk!

Jeg skulle prøve enda mer worst case på varme, ved å belaste GPU også. [Tror det var Cyberpunk-utviklerne som sa at det var bare å forberede seg på at spill bruker 100% av både CPU og GPU.] Jeg har noen programmer som kan bruke "100%" GPU, men strømbruken var bare 150W, mye mindre enn max ca 400W mulig. Vet ikke, det får holde for nå, ta det når det kommer

Edit: Det er forresten rart, jeg fikk disse feilene selv med åpent kabinett, skulle tro det ga god nok lufting. Det var en helt klar overgang når jeg satt en vifte mot minnet, men lurer på om det også kan ha hjulpet at jeg tok ut minnet og satt det inn hardere.